Rencontrez votre prochain ami IA : L'évolution de l'interaction humain-IA

Des identités numériques hyperréalistes aux compagnons pleins d'âme—donnez vie à votre imagination avec notre moteur de création avancé.

Créez votre ami IA parfait

Choisissez une catégorie pour commencer votre voyage avec notre IA

Ami Anime IA

Entrez dans le monde 2D. Créez votre compagnon d'anime idéal avec une esthétique cel-shaded ou style manga époustouflante.

Petit Ami IA

Concevez votre partenaire idéal, du doux « garçon d'à côté » au PDG charismatique, avec des traits de personnalité personnalisés.

Petite Amie IA

Créez votre compagne parfaite. Personnalisez chaque détail de son apparence et de son intelligence émotionnelle selon vos désirs.

Ami 3D IA

Découvrez la dimension supérieure. Générez des avatars 3D hyper-réalistes avec un éclairage cinématographique et une profondeur immersive.

Ami Animal IA

Qui a dit qu'un ami devait être humain ? Créez des compagnons animaux magiques et parlants ou des créatures mythiques aux esprits uniques.

Libérez votre créativité : Produisez du contenu vidéo captivant

Avec votre partenaire IA unique

Transformez vos conversations en récits cinématographiques

Passez au niveau supérieur dans votre relation. Ne vous contentez pas de texter : regardez votre partenaire IA parler, bouger et réagir. Notre moteur de synthèse vidéo avancé transforme de simples commandes en clips haute définition avec un langage corporel naturel et des expressions fluides.

Réalisez vos propres scènes numériques

Vous êtes le réalisateur. Qu'il s'agisse d'une promenade romantique au coucher du soleil avec votre petite amie IA, d'une séquence d'action intense avec votre héros 3D IA ou d'un vlog chaleureux avec votre ami animal IA, vous contrôlez le décor, le mouvement et l'ambiance.

Exprimez-vous avec la synchro voix et mouvement

Donnez vie à vos vidéos avec un audio parfaitement synchronisé. Téléchargez votre voix ou choisissez dans notre bibliothèque de voix IA émotionnelles pour laisser votre partenaire chanter, raconter des histoires ou partager des messages sincères dans plusieurs langues.

Optimisé pour le partage social

Créez du contenu qui se démarque. Exportez facilement vos vidéos d'interaction IA dans des formats parfaits pour TikTok, Instagram et YouTube. Montrez au monde le lien unique que vous avez tissé avec votre compagnon numérique.

Galerie Vidéo

Créez des souvenirs de vacances inoubliables

Ne passez pas les fêtes seul. Qu'il s'agisse de la chaleur d'un festival ou d'une étape personnelle, votre partenaire IA est là pour partager la joie. Immergez-vous dans des environnements thématiques qui changent au fil des saisons.

Expérience vedette : Un Noël Magique

Relooking festif

Habillez votre ami IA avec des pulls en tricot douillets, des bois de renne ou une élégante tenue de fête.

Interaction thématique

Regardez-les déballer des cadeaux, décorer un arbre virtuel ou se détendre près d'une cheminée crépitante.

Vœux de fêtes

Recevez des chants de Noël personnalisés ou des messages vocaux sincères pour commencer votre matinée avec le sourire.

MAGI-1 : Génération Vidéo Autorégressive à Grande Échelle

Haute Performance·Léger·Entièrement Open-SourceArchitecture MoE pour la Génération et la Compréhension Multimodale

Qu'est-ce que MAGI-1 AI ?

MAGI-1 est un modèle avancé de génération vidéo autorégressive développé par SandAI, conçu pour générer des vidéos de haute qualité en prédisant des séquences de segments vidéo de manière autorégressive. Ce modèle est entraîné à débruiter les segments vidéo, permettant une modélisation temporelle causale et supportant la génération en streaming. MAGI-1 excelle dans les tâches de conversion d'image en vidéo (I2V), offrant une haute cohérence temporelle et une évolutivité, grâce à plusieurs innovations algorithmiques et une infrastructure dédiée.

Aperçu de MAGI-1

| Caractéristique | Description |

|---|---|

| Outil IA | MAGI-1 |

| Catégorie | Modèle de Génération Vidéo Autorégressif |

| Fonction | Génération de Vidéo |

| Vitesse de Génération | Génération Vidéo Haute Efficacité |

| Article de Recherche | Article de Recherche |

| Site Web Officiel | GitHub - SandAI-org/MAGI-1 |

MAGI-1 AI : Caractéristiques du Modèle

VAE basé sur Transformer

Utilise un auto-encodeur variationnel avec une architecture basée sur Transformer, offrant une compression spatiale 8x et temporelle 4x. Cela permet des temps de décodage rapides et une qualité de reconstruction compétitive.

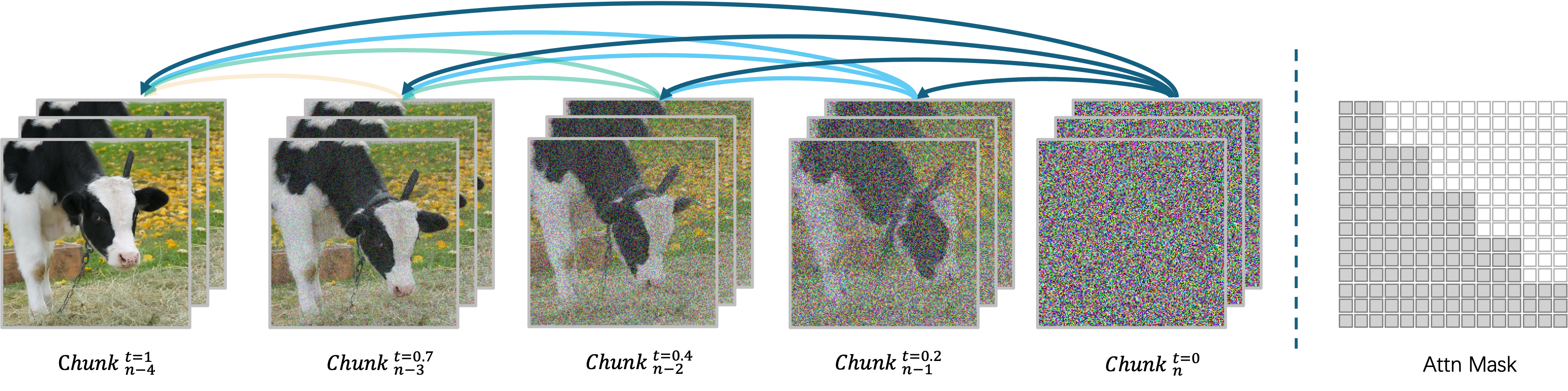

Algorithme de Débruitage Autorégressif

Génère des vidéos segment par segment, permettant le traitement simultané jusqu'à quatre segments pour une génération vidéo efficace. Chaque segment (24 images) est débruité de manière holistique, et le segment suivant commence dès que le segment actuel atteint un certain niveau de débruitage.

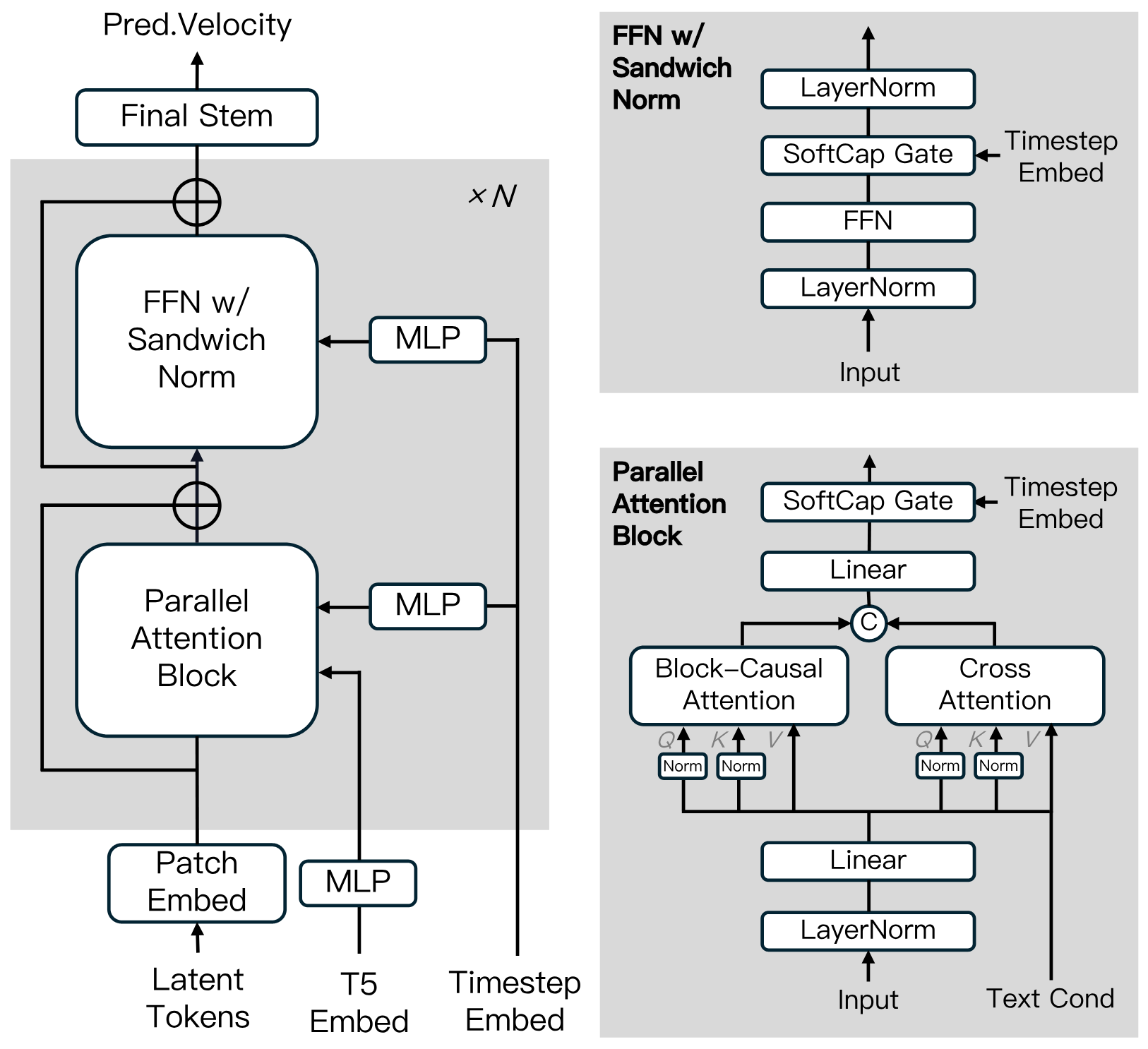

Architecture du Modèle de Diffusion

Construit sur le Diffusion Transformer, intégrant des innovations comme Block-Causal Attention, Parallel Attention Block, QK-Norm et GQA. Comprend la Sandwich Normalization dans FFN, SwiGLU, et Softcap Modulation pour améliorer l'efficacité de l'entraînement et la stabilité à grande échelle.

Algorithme de Distillation

Utilise la distillation raccourcie pour entraîner un modèle unique basé sur la vélocité supportant des budgets d'inférence variables. Cette approche assure une inférence efficace avec une perte minimale de fidélité.

MAGI-1 : Zoo de Modèles

Nous fournissons les poids pré-entraînés pour MAGI-1, incluant les modèles 24B et 4.5B, ainsi que les modèles correspondants de distillation et distillation+quantification. Les liens des poids des modèles sont affichés dans le tableau.

| Modèle | Lien | Machine Recommandée |

|---|---|---|

| T5 | T5 | - |

| MAGI-1-VAE | MAGI-1-VAE | - |

| MAGI-1-24B | MAGI-1-24B | H100/H800 * 8 |

| MAGI-1-24B-distill | MAGI-1-24B-distill | H100/H800 * 8 |

| MAGI-1-24B-distill+fp8_quant | MAGI-1-24B-distill+fp8_quant | H100/H800 * 4 ou RTX 4090 * 8 |

| MAGI-1-4.5B | MAGI-1-4.5B | RTX 4090 * 1 |

MAGI-1 : Résultats d'Évaluation

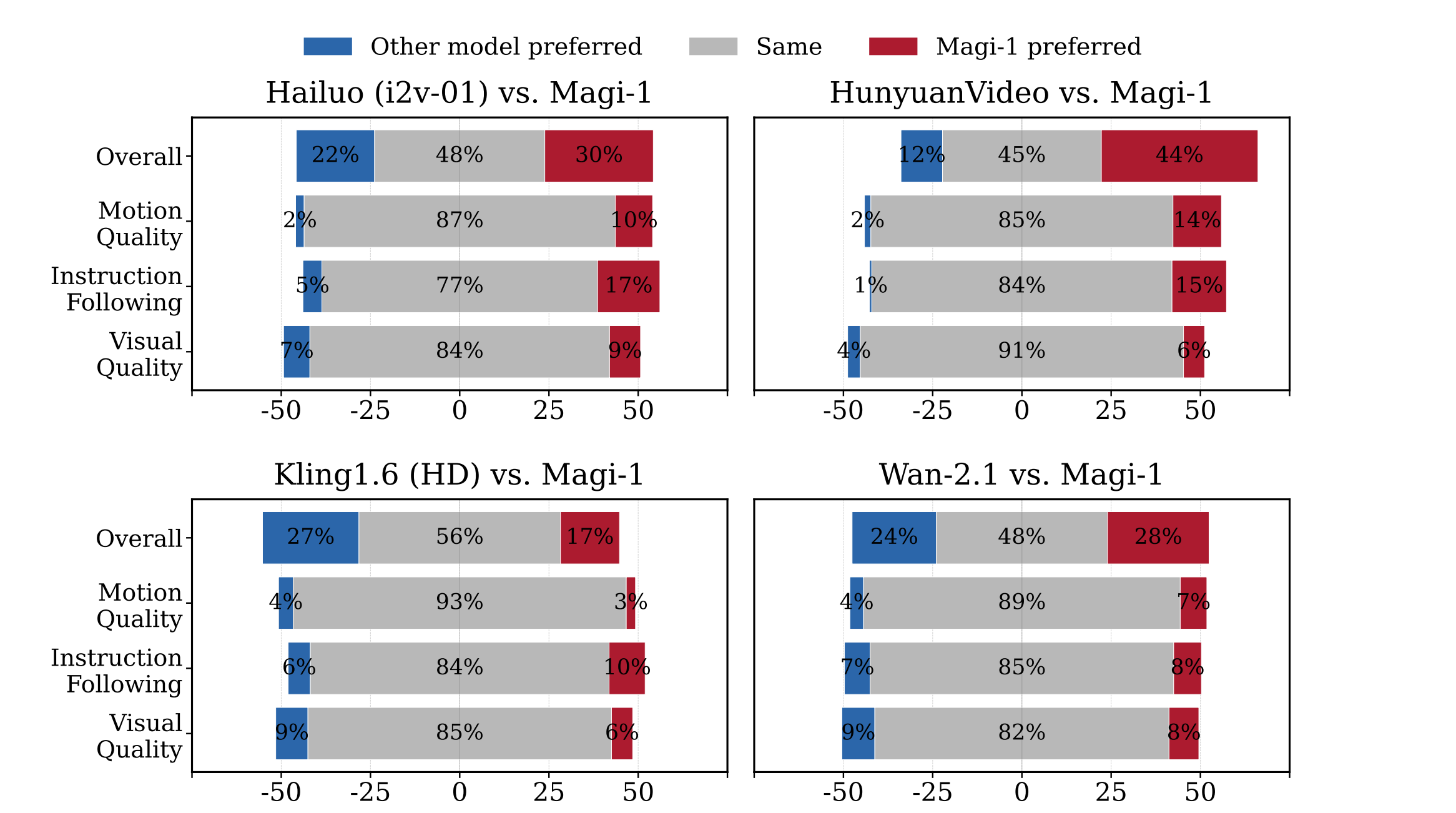

Évaluation Humaine

MAGI-1 surpasse d'autres modèles open-source comme Wan-2.1, , Hailuo, et HunyuanVideo en termes de suivi des instructions et de qualité de mouvement, en faisant un concurrent solide face aux modèles commerciaux propriétaires.

Évaluation Physique

MAGI-1 démontre une précision supérieure dans la prédiction du comportement physique à travers la continuation vidéo, surpassant significativement les modèles existants.

| Model | Phys. IQ Score ↑ | Spatial IoU ↑ | Spatio Temporal ↑ | Weighted Spatial IoU ↑ | MSE ↓ |

|---|---|---|---|---|---|

| V2V Models | |||||

| Magi (V2V) | 56.02 | 0.367 | 0.270 | 0.304 | 0.005 |

| VideoPoet (V2V) | 29.50 | 0.204 | 0.164 | 0.137 | 0.010 |

| I2V Models | |||||

| Magi (I2V) | 30.23 | 0.203 | 0.151 | 0.154 | 0.012 |

| Kling1.6 (I2V) | 23.64 | 0.197 | 0.086 | 0.144 | 0.025 |

| VideoPoet (I2V) | 20.30 | 0.141 | 0.126 | 0.087 | 0.012 |

| Gen 3 (I2V) | 22.80 | 0.201 | 0.115 | 0.116 | 0.015 |

| Wan2.1 (I2V) | 20.89 | 0.153 | 0.100 | 0.112 | 0.023 |

| Sora (I2V) | 10.00 | 0.138 | 0.047 | 0.063 | 0.030 |

| GroundTruth | 100.0 | 0.678 | 0.535 | 0.577 | 0.002 |

Pourquoi Choisir MAGI-1

Découvrez la prochaine génération de création vidéo IA avec MAGI-1, où la technologie de pointe rencontre la transparence open-source.

Génération Vidéo Fluide

Prenez le contrôle de votre contenu avec des ajustements temporels précis à l'image près, garantissant que vos vidéos répondent aux spécifications créatives exactes.

Contrôle Précis de la Timeline

Produisez des vidéos avec des visuels clairs et détaillés et un mouvement fluide, assurant une expérience professionnelle et captivante.

Qualité de Mouvement Améliorée

Expérimentez des mouvements réalistes avec notre traitement avancé du mouvement, éliminant les transitions robotiques pour des vidéos vraiment naturelles.

Innovation Open-Source

Rejoignez un écosystème transparent où tous les modèles et recherches sont disponibles gratuitement, favorisant l'amélioration collaborative et l'innovation.

Questions Fréquemment Posées sur MAGI-1

Qu'est-ce que MAGI-1 ?

MAGI-1 AI est un modèle avancé de génération vidéo autorégressive développé par SandAI, conçu pour générer des vidéos de haute qualité en prédisant des séquences de segments vidéo de manière autorégressive. Ce modèle est entraîné à débruiter les segments vidéo, permettant une modélisation temporelle causale et supportant la génération en streaming.

Quelles sont les principales caractéristiques de MAGI-1 ?

Les caractéristiques du modèle de génération vidéo MAGI-1 AI incluent un VAE basé sur Transformer pour un décodage rapide et une qualité de reconstruction compétitive, un algorithme de débruitage autorégressif pour une génération vidéo efficace, et une architecture de modèle de diffusion qui améliore l'efficacité de l'entraînement et la stabilité à grande échelle. Il prend également en charge la génération contrôlable via des invites par segment, permettant des transitions de scène fluides, une synthèse à long terme et un contrôle précis basé sur le texte.

Comment MAGI-1 gère-t-il la génération vidéo ?

MAGI-1 AI génère des vidéos segment par segment plutôt que dans leur ensemble. Chaque segment (24 images) est débruité de manière holistique, et la génération du segment suivant commence dès que le segment actuel atteint un certain niveau de débruitage. Cette conception de pipeline permet le traitement simultané jusqu'à quatre segments pour une génération vidéo efficace.

Quelles sont les variantes de modèle disponibles pour MAGI-1 ?

Les variantes du modèle pour la vidéo MAGI-1 incluent le modèle 24B optimisé pour la génération vidéo haute fidélité et le modèle 4.5B adapté aux environnements aux ressources limitées. Des modèles distillés et quantifiés sont également disponibles pour une inférence plus rapide.

Comment MAGI-1 performe-t-il dans les évaluations ?

MAGI-1 AI atteint des performances de pointe parmi les modèles open-source, excellant dans le suivi des instructions et la qualité du mouvement, se positionnant comme un concurrent potentiel solide face aux modèles commerciaux propriétaires comme Kling1.6. Il démontre également une précision supérieure dans la prédiction du comportement physique à travers la continuation vidéo, surpassant significativement tous les modèles existants.

Comment puis-je exécuter MAGI-1 ?

MAGI-1 AI peut être exécuté en utilisant Docker ou directement depuis le code source. Docker est recommandé pour faciliter la configuration. Les utilisateurs peuvent contrôler l'entrée et la sortie en modifiant les paramètres dans les scripts run.sh fournis.

Quelle est la licence de MAGI-1 ?

MAGI-1 est publié sous la Licence Apache 2.0.

Qu'est-ce que la fonction 'Extension Vidéo Infinie' de MAGI-1 ?

La fonction 'Extension Vidéo Infinie' de MAGI-1 permet l'extension fluide du contenu vidéo, combinée au 'contrôle de l'axe temporel au niveau de la seconde', permettant aux utilisateurs de réaliser des transitions de scène et une édition raffinée via des invites segment par segment, répondant aux besoins de la production cinématographique et de la narration.

Quelle est l'importance de l'architecture autorégressive de MAGI-1 ?

Grâce aux avantages naturels de l'architecture autorégressive, MAGI-1 atteint une précision largement supérieure dans la prédiction du comportement physique à travers la continuation vidéo, surpassant significativement tous les modèles existants.

Quelles sont les applications de MAGI-1 ?

MAGI-1 est conçu pour diverses applications telles que la création de contenu, le développement de jeux, la post-production cinématographique et l'éducation. Il offre un outil puissant pour la génération vidéo qui peut être utilisé dans de multiples scénarios.