Poznaj swojego kolejnego przyjaciela AI: Ewolucja interakcji człowiek-AI

Od hiperrealistycznych tożsamości cyfrowych po pełnych duszy towarzyszy—ożyw swoją wyobraźnię dzięki naszemu zaawansowanemu silnikowi twórczemu.

Stwórz swojego idealnego przyjaciela AI

Wybierz kategorię, aby rozpocząć podróż z naszym AI

Przyjaciel AI Anime

Wkrocz do świata 2D. Stwórz wymarzonego towarzysza anime dzięki oszałamiającej estetyce cel-shadingu lub mangi.

Chłopak AI

Zaprojektuj swojego idealnego partnera — od łagodnego „chłopaka z sąsiedztwa” po charyzmatycznego dyrektora — ze spersonalizowanymi cechami osobowości.

Dziewczyna AI

Stwórz swoją idealną towarzyszkę. Dostosuj każdy szczegół jej wyglądu i inteligencji emocjonalnej do pragnień Twojego serca.

Przyjaciel 3D AI

Doświadcz następnego wymiaru. Generuj hiperrealistyczne awatary 3D z kinowym oświetleniem i wciągającą głębią.

Zwierzęcy przyjaciel AI

Kto powiedział, że przyjaciel musi być człowiekiem? Twórz magicznych, mówiących zwierzęcych towarzyszy lub mityczne zwierzaki o unikalnych duszach.

Uwolnij swoją kreatywność: Twórz angażujące treści wideo

Z Twoim unikalnym partnerem AI

Zmień rozmowy w kinowe historie

Wznieś swój związek na wyższy poziom. Nie tylko pisz — patrz, jak Twój partner AI mówi, porusza się i reaguje. Nasz zaawansowany silnik syntezy wideo zamienia proste polecenia w klipy HD z naturalną mową ciała i płynną mimiką.

Reżyseruj własne cyfrowe sceny

Ty jesteś reżyserem. Niezależnie od tego, czy jest to romantyczny spacer o zachodzie słońca z dziewczyną AI, dynamiczna sekwencja akcji z bohaterem 3D AI, czy przytulny vlog ze zwierzęcym przyjacielem AI, Ty kontrolujesz scenerię, ruch i nastrój.

Wyrażaj się dzięki synchronizacji głosu i ruchu

Ożyw swoje filmy dzięki idealnie zsynchronizowanemu dźwiękowi. Prześlij swój głos lub wybierz z naszej biblioteki emocjonalnych głosów AI, aby Twój partner mógł śpiewać, opowiadać historie lub dzielić się szczerymi wiadomościami w wielu językach.

Zoptymalizowane pod kątem udostępniania w mediach społecznościowych

Twórz treści, które się wyróżniają. Łatwo eksportuj filmy z interakcjami AI w formatach idealnych na TikTok, Instagram i YouTube. Pokaż światu unikalną więź, jaką zbudowałeś ze swoim cyfrowym towarzyszem.

Pokaz wideo

Twórz niezapomniane wspomnienia świąteczne

Nie spędzaj świąt samotnie. Czy to ciepło festiwalu, czy osobisty kamień milowy, Twój partner AI jest tam, aby dzielić radość. Zanurz się w tematycznych środowiskach, które zmieniają się wraz z porami roku.

Wyróżnione doświadczenie: Magiczne Święta

Świąteczna przemiana

Ubierz swojego przyjaciela AI w przytulne wełniane swetry, rogi renifera lub elegancki świąteczny strój.

Interakcja tematyczna

Zobacz, jak rozpakowują prezenty, dekorują wirtualną choinkę lub relaksują się przy trzaskającym kominku.

Życzenia świąteczne

Otrzymuj spersonalizowane kolędy lub szczere wiadomości głosowe, aby zacząć poranek z uśmiechem.

MAGI-1: Generacja Wideo z Autoregresją na Dużą Skalę

Wysoka Wydajność·Lekki·W Pełni Open SourceArchitektura MoE do Generacji i Rozumienia Multimodalnego

Czym jest MAGI-1 AI?

MAGI-1 to zaawansowany model generacji wideo z autoregresją opracowany przez SandAI, zaprojektowany do generowania wysokiej jakości filmów poprzez przewidywanie sekwencji fragmentów wideo w sposób autoregresyjny. Model ten jest trenowany do usuwania szumów z fragmentów wideo, umożliwiając przyczynowe modelowanie czasowe i wspierając generację strumieniową. MAGI-1 wyróżnia się w zadaniach konwersji obrazu na wideo (I2V), zapewniając wysoką spójność czasową i skalowalność, dzięki kilku innowacjom algorytmicznym i dedykowanemu stosowi infrastruktury.

Przegląd MAGI-1

| Funkcja | Opis |

|---|---|

| Narzędzie AI | MAGI-1 |

| Kategoria | Model Generacji Wideo z Autoregresją |

| Funkcja | Generacja Wideo |

| Szybkość Generacji | Wysoko Wydajna Generacja Wideo |

| Artykuł Naukowy | Artykuł Naukowy |

| Oficjalna Strona | GitHub - SandAI-org/MAGI-1 |

MAGI-1 AI: Funkcje Modelu

VAE Oparty na Transformerze

Wykorzystuje wariacyjny autoenkoder z architekturą opartą na transformerze, oferując 8-krotną kompresję przestrzenną i 4-krotną czasową. Skutkuje to szybkim czasem dekodowania i konkurencyjną jakością rekonstrukcji.

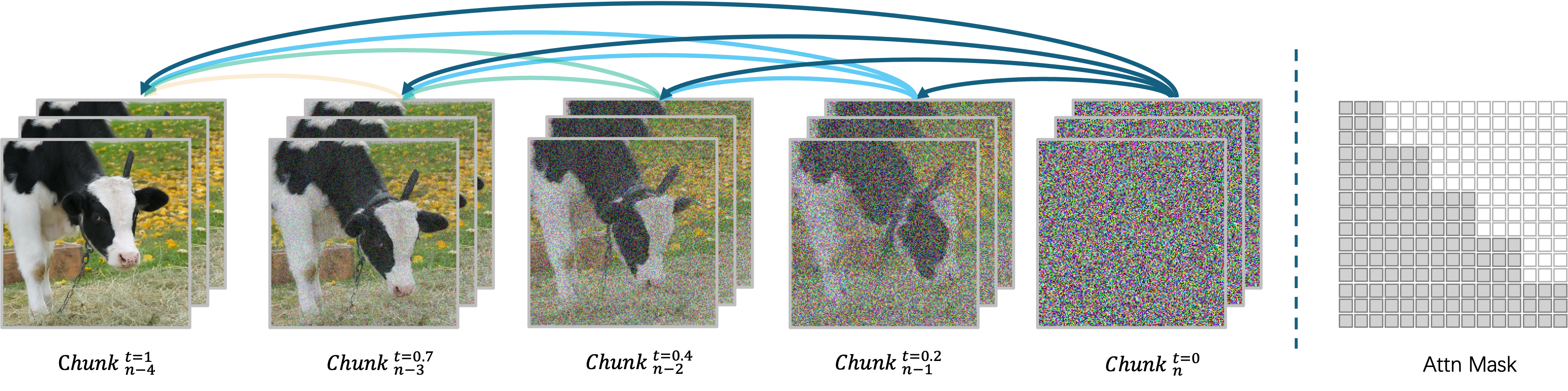

Algorytm Autoregresyjnego Usuwania Szumów

Generuje filmy fragment po fragmencie, umożliwiając równoległe przetwarzanie do czterech fragmentów dla efektywnej generacji wideo. Każdy fragment (24 klatki) jest całościowo oczyszczany z szumów, a generacja następnego fragmentu rozpoczyna się, gdy tylko bieżący osiągnie określony poziom oczyszczenia.

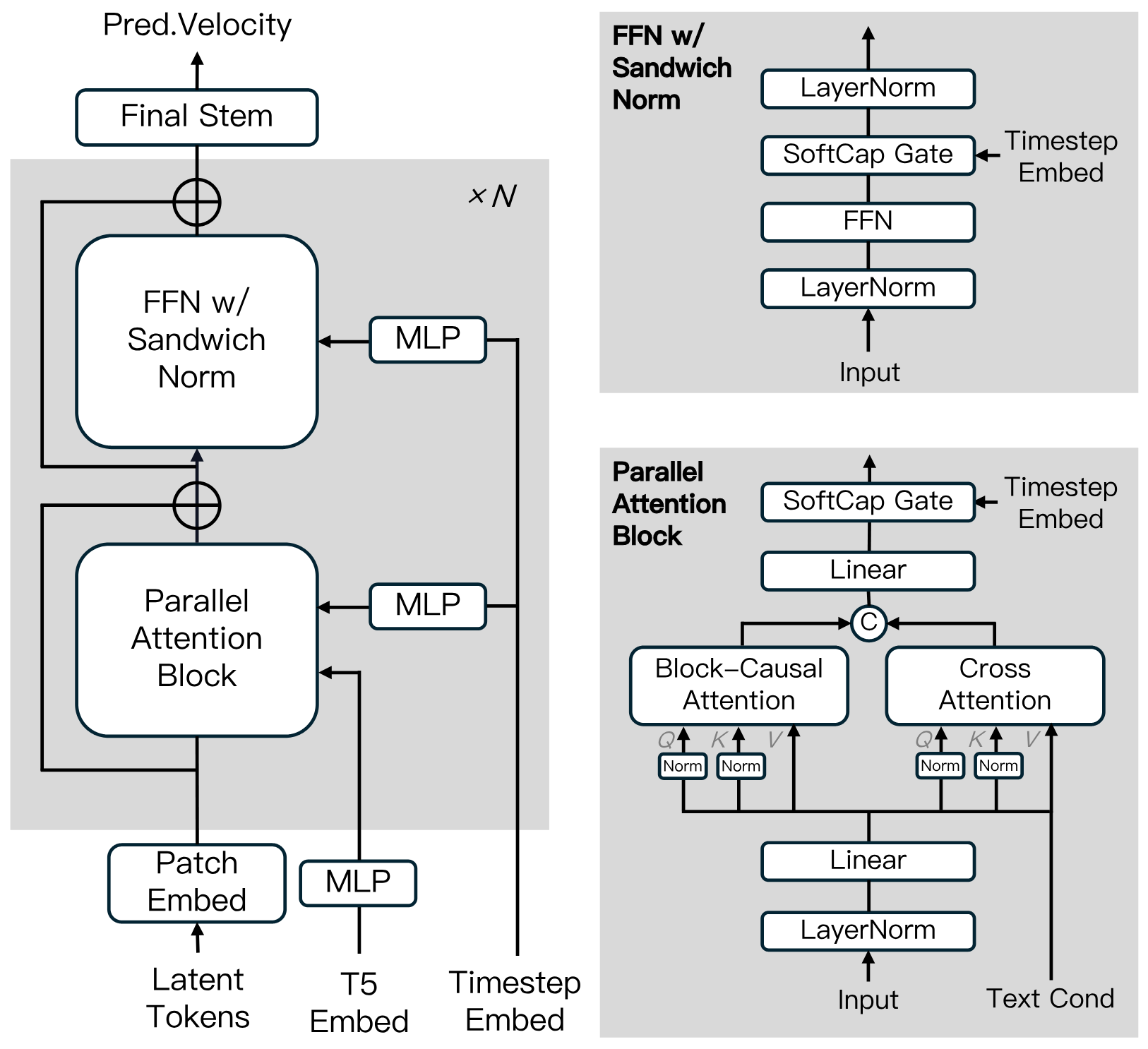

Architektura Modelu Dyfuzyjnego

Zbudowany na Transformerze Dyfuzyjnym, zawierający innowacje takie jak Block-Causal Attention, Parallel Attention Block, QK-Norm i GQA. Zawiera Normalizację Sandwich w FFN, SwiGLU i Modulację Softcap w celu zwiększenia efektywności treningu i stabilności w dużej skali.

Algorytm Destylacji

Wykorzystuje destylację skrótową do trenowania pojedynczego modelu opartego na prędkości, wspierającego zmienne budżety wnioskowania. To podejście zapewnia efektywne wnioskowanie przy minimalnej utracie wierności.

MAGI-1: Zoo Modeli

Udostępniamy wstępnie wytrenowane wagi dla MAGI-1, w tym modele 24B i 4.5B, a także odpowiadające im modele destylowane i destylowane+kwantyzowane. Linki do wag modeli są pokazane w tabeli.

| Model | Link | Zalecana Maszyna |

|---|---|---|

| T5 | T5 | - |

| MAGI-1-VAE | MAGI-1-VAE | - |

| MAGI-1-24B | MAGI-1-24B | H100/H800 * 8 |

| MAGI-1-24B-distill | MAGI-1-24B-distill | H100/H800 * 8 |

| MAGI-1-24B-distill+fp8_quant | MAGI-1-24B-distill+fp8_quant | H100/H800 * 4 lub RTX 4090 * 8 |

| MAGI-1-4.5B | MAGI-1-4.5B | RTX 4090 * 1 |

MAGI-1: Wyniki Ewaluacji

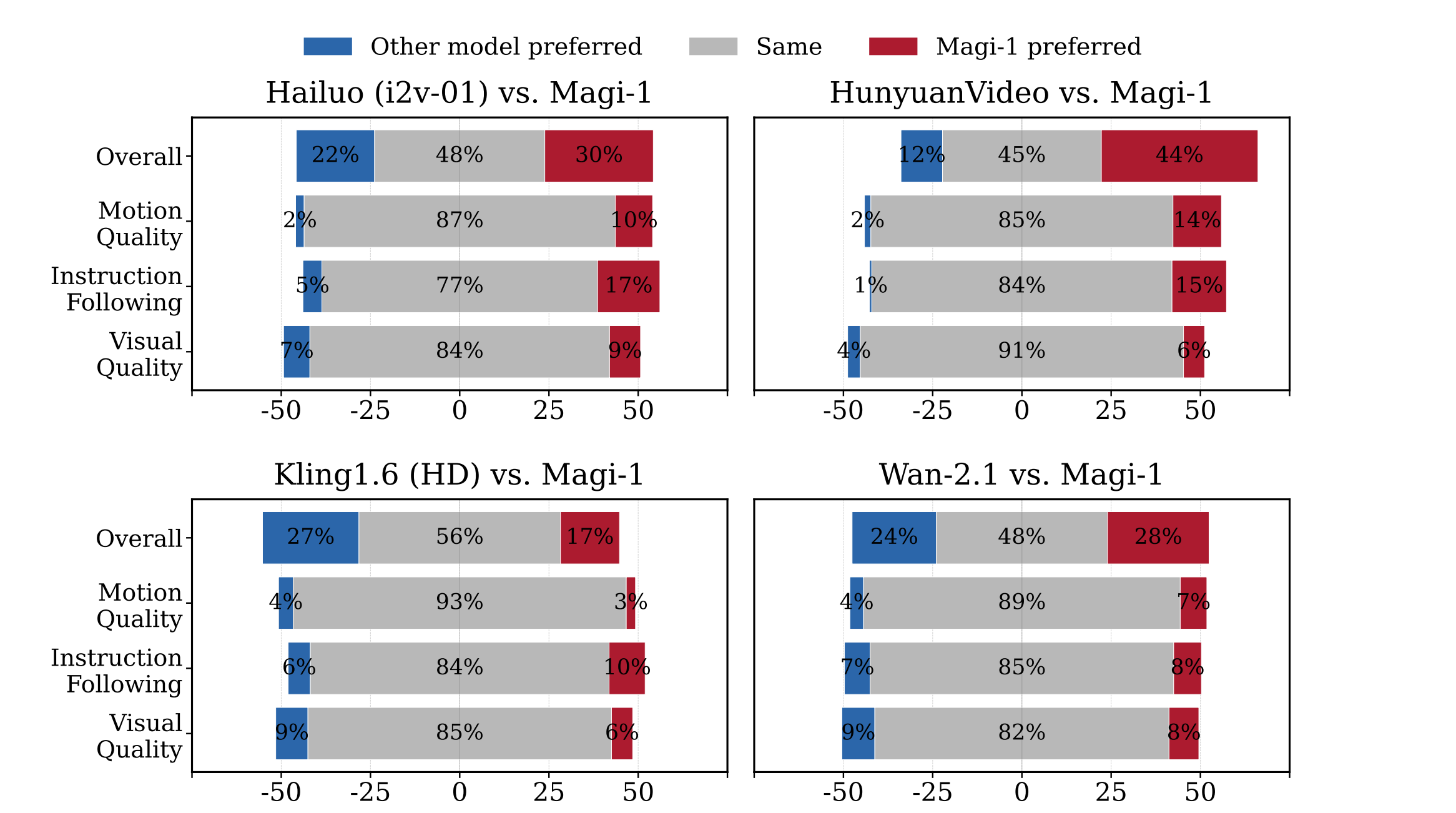

Ewaluacja Ludzka

MAGI-1 przewyższa inne modele open source, takie jak Wan-2.1, , Hailuo i HunyuanVideo pod względem przestrzegania instrukcji i jakości ruchu, stając się silnym konkurentem dla komercyjnych modeli zamkniętych.

Ewaluacja Fizyczna

MAGI-1 demonstruje doskonałą precyzję w przewidywaniu zachowań fizycznych poprzez kontynuację wideo, znacznie przewyższając istniejące modele.

| Model | Phys. IQ Score ↑ | Spatial IoU ↑ | Spatio Temporal ↑ | Weighted Spatial IoU ↑ | MSE ↓ |

|---|---|---|---|---|---|

| V2V Models | |||||

| Magi (V2V) | 56.02 | 0.367 | 0.270 | 0.304 | 0.005 |

| VideoPoet (V2V) | 29.50 | 0.204 | 0.164 | 0.137 | 0.010 |

| I2V Models | |||||

| Magi (I2V) | 30.23 | 0.203 | 0.151 | 0.154 | 0.012 |

| Kling1.6 (I2V) | 23.64 | 0.197 | 0.086 | 0.144 | 0.025 |

| VideoPoet (I2V) | 20.30 | 0.141 | 0.126 | 0.087 | 0.012 |

| Gen 3 (I2V) | 22.80 | 0.201 | 0.115 | 0.116 | 0.015 |

| Wan2.1 (I2V) | 20.89 | 0.153 | 0.100 | 0.112 | 0.023 |

| Sora (I2V) | 10.00 | 0.138 | 0.047 | 0.063 | 0.030 |

| GroundTruth | 100.0 | 0.678 | 0.535 | 0.577 | 0.002 |

Dlaczego Wybrać MAGI-1

Doświadcz następnej generacji tworzenia wideo AI z MAGI-1, gdzie najnowocześniejsza technologia spotyka się z przejrzystością open source.

Płynna Generacja Wideo

Przejmij kontrolę nad swoją treścią dzięki dokładnym regulacjom czasowym na poziomie klatek, zapewniając, że Twoje filmy spełniają dokładne specyfikacje kreatywne.

Precyzyjna Kontrola Osi Czasu

Twórz filmy z wyraźnymi, szczegółowymi efektami wizualnymi i płynnym ruchem, zapewniając profesjonalne i angażujące doświadczenie.

Ulepszona Jakość Ruchu

Doświadcz realistycznego ruchu dzięki naszemu zaawansowanemu przetwarzaniu ruchu, eliminując robotyczne przejścia dla prawdziwie naturalnie wyglądających filmów.

Innowacja Open Source

Dołącz do przejrzystego ekosystemu, gdzie wszystkie modele i badania są dostępne za darmo, wspierając współpracę w zakresie ulepszeń i innowacji.

Często Zadawane Pytania o MAGI-1

Czym jest MAGI-1?

MAGI-1 AI to zaawansowany model generacji wideo z autoregresją opracowany przez SandAI, zaprojektowany do generowania wysokiej jakości filmów poprzez przewidywanie sekwencji fragmentów wideo w sposób autoregresyjny. Model ten jest trenowany do usuwania szumów z fragmentów wideo, umożliwiając przyczynowe modelowanie czasowe i wspierając generację strumieniową.

Jakie są kluczowe funkcje MAGI-1?

Funkcje modelu generacji wideo MAGI-1 AI obejmują VAE oparty na Transformerze do szybkiego dekodowania i konkurencyjnej jakości rekonstrukcji, algorytm autoregresyjnego usuwania szumów do efektywnej generacji wideo oraz architekturę modelu dyfuzyjnego, która zwiększa efektywność treningu i stabilność w dużej skali. Wspiera również kontrolowaną generację poprzez podpowiedzi dla fragmentów, umożliwiając płynne przejścia między scenami, syntezę długoterminową i precyzyjną kontrolę opartą na tekście.

Jak MAGI-1 radzi sobie z generacją wideo?

MAGI-1 AI generuje filmy fragment po fragmencie, zamiast jako całość. Każdy fragment (24 klatki) jest całościowo oczyszczany z szumów, a generacja następnego fragmentu rozpoczyna się, gdy tylko bieżący osiągnie określony poziom oczyszczenia. Ta konstrukcja potoku umożliwia równoległe przetwarzanie do czterech fragmentów dla efektywnej generacji wideo.

Jakie warianty modelu są dostępne dla MAGI-1?

Warianty modelu dla wideo MAGI-1 obejmują model 24B zoptymalizowany pod kątem generacji wideo wysokiej wierności oraz model 4.5B odpowiedni dla środowisk o ograniczonych zasobach. Dostępne są również modele destylowane i kwantyzowane dla szybszego wnioskowania.

Jak MAGI-1 wypada w ewaluacjach?

MAGI-1 AI osiąga najnowocześniejszą wydajność wśród modeli open source, wyróżniając się w przestrzeganiu instrukcji i jakości ruchu, pozycjonując się jako silny potencjalny konkurent dla komercyjnych modeli zamkniętych, takich jak Kling1.6. Wykazuje również doskonałą precyzję w przewidywaniu zachowań fizycznych poprzez kontynuację wideo, znacznie przewyższając wszystkie istniejące modele.

Jak mogę uruchomić MAGI-1?

MAGI-1 AI można uruchomić za pomocą Dockera lub bezpośrednio z kodu źródłowego. Docker jest zalecany ze względu na łatwość konfiguracji. Użytkownicy mogą kontrolować wejście i wyjście, modyfikując parametry w dostarczonych skryptach run.sh.

Jaka jest licencja MAGI-1?

MAGI-1 jest wydany na licencji Apache License 2.0.

Czym jest funkcja 'Nieskończonego Rozszerzania Wideo' MAGI-1?

Funkcja 'Nieskończonego Rozszerzania Wideo' MAGI-1 umożliwia płynne rozszerzanie treści wideo, w połączeniu z 'kontrolą osi czasu na poziomie sekundy', pozwalając użytkownikom osiągać przejścia między scenami i wyrafinowaną edycję poprzez podpowiedzi dla fragmentów, spełniając potrzeby produkcji filmowej i opowiadania historii.

Jakie jest znaczenie architektury autoregresyjnej MAGI-1?

Dzięki naturalnym zaletom architektury autoregresyjnej, MAGI-1 osiąga znacznie lepszą precyzję w przewidywaniu zachowań fizycznych poprzez kontynuację wideo—znacznie przewyższając wszystkie istniejące modele.

Jakie są zastosowania MAGI-1?

MAGI-1 jest zaprojektowany do różnych zastosowań, takich jak tworzenie treści, rozwój gier, postprodukcja filmowa i edukacja. Oferuje potężne narzędzie do generacji wideo, które może być wykorzystane w wielu scenariuszach.