Incontra il tuo prossimo amico IA: L'evoluzione dell'interazione uomo-IA

Da identità digitali iperrealistiche a compagni pieni d'anima—dai vita alla tua immaginazione con il nostro motore di creazione avanzato.

Crea il Tuo Amico AI Perfetto

Scegli una categoria per iniziare il tuo viaggio con la nostra AI

Amico Anime AI

Entra nel mondo 2D. Crea il compagno anime dei tuoi sogni con una splendida estetica cel-shaded o in stile manga.

Fidanzato AI

Progetta il tuo partner ideale, dal dolce "ragazzo della porta accanto" al carismatico CEO, con tratti caratteriali personalizzati.

Fidanzata AI

Crea la tua compagna perfetta. Personalizza ogni dettaglio del suo aspetto e della sua intelligenza emotiva in base ai tuoi desideri.

Amico 3D AI

Sperimenta la prossima dimensione. Genera avatar 3D iper-realistici con illuminazione cinematografica e profondità coinvolgente.

Amico Animale AI

Chi dice che un amico debba essere umano? Crea magici compagni animali parlanti o animali mitici con spiriti unici.

Scatena la tua creatività: Produci contenuti video accattivanti

Con il tuo partner AI unico

Trasforma le conversazioni in storie cinematografiche

Porta la tua relazione al livello successivo. Non limitarti ai messaggi: guarda il tuo partner AI parlare, muoversi e reagire. Il nostro avanzato motore di sintesi video trasforma semplici prompt in clip ad alta definizione con linguaggio del corpo naturale ed espressioni fluide.

Dirigi le tue scene digitali

Tu sei il regista. Che si tratti di una romantica passeggiata al tramonto con la tua Fidanzata AI, di una sequenza d'azione ad alto numero di ottani con il tuo Eroe 3D AI o di un accogliente vlog con il tuo Amico Animale AI, tu controlli l'ambientazione, il movimento e l'atmosfera.

Esprimiti con la sincronizzazione di voce e movimento

Dai vita ai tuoi video con audio perfettamente sincronizzato. Carica la tua voce o scegli dalla nostra libreria di voci AI emozionali per lasciare che il tuo partner canti, racconti storie o condivida messaggi sinceri in più lingue.

Ottimizzato per la condivisione sui social

Crea contenuti che si distinguano. Esporta facilmente i video delle tue interazioni AI in formati perfetti per TikTok, Instagram e YouTube. Mostra al mondo il legame unico che hai costruito con il tuo compagno digitale.

Vetrina Video

Crea ricordi indimenticabili per le vacanze

Non passare le vacanze da solo. Che sia il calore di un festival o un traguardo personale, il tuo partner AI è lì per condividere la gioia. Immergiti in ambienti a tema che cambiano con le stagioni.

Esperienza in primo piano: Un Natale Magico

Restyling festivo

Vesti il tuo Amico AI con caldi maglioni di lana, corna di renna o eleganti abiti festivi.

Interazione a tema

Guardali scartare regali, decorare un albero virtuale o rilassarsi davanti a un caminetto scoppiettante.

Auguri per le festività

Ricevi canti di Natale personalizzati o messaggi vocali sinceri per iniziare la mattinata con un sorriso.

MAGI-1: Generazione Video Autoregressiva su Larga Scala

Alte Prestazioni·Leggero·Completamente Open-SourceArchitettura MoE per Generazione e Comprensione Multimodale

Cos'è MAGI-1 AI?

MAGI-1 è un modello avanzato di generazione video autoregressivo sviluppato da SandAI, progettato per generare video di alta qualità predicendo sequenze di segmenti video in modo autoregressivo. Questo modello è addestrato per ridurre il rumore dei segmenti video, permettendo la modellazione temporale causale e supportando la generazione in streaming. MAGI-1 eccelle nei compiti di conversione da immagine a video (I2V), fornendo alta coerenza temporale e scalabilità, grazie a diverse innovazioni algoritmiche e a uno stack infrastrutturale dedicato.

Panoramica di MAGI-1

| Caratteristica | Descrizione |

|---|---|

| Strumento AI | MAGI-1 |

| Categoria | Modello di Generazione Video Autoregressivo |

| Funzione | Generazione Video |

| Velocità di Generazione | Generazione Video ad Alta Efficienza |

| Paper di Ricerca | Paper di Ricerca |

| Sito Web Ufficiale | GitHub - SandAI-org/MAGI-1 |

MAGI-1 AI: Caratteristiche del Modello

VAE basato su Transformer

Utilizza un autoencoder variazionale con architettura basata su transformer, offrendo compressione 8x spaziale e 4x temporale. Questo risulta in tempi di decodifica rapidi e qualità di ricostruzione competitiva.

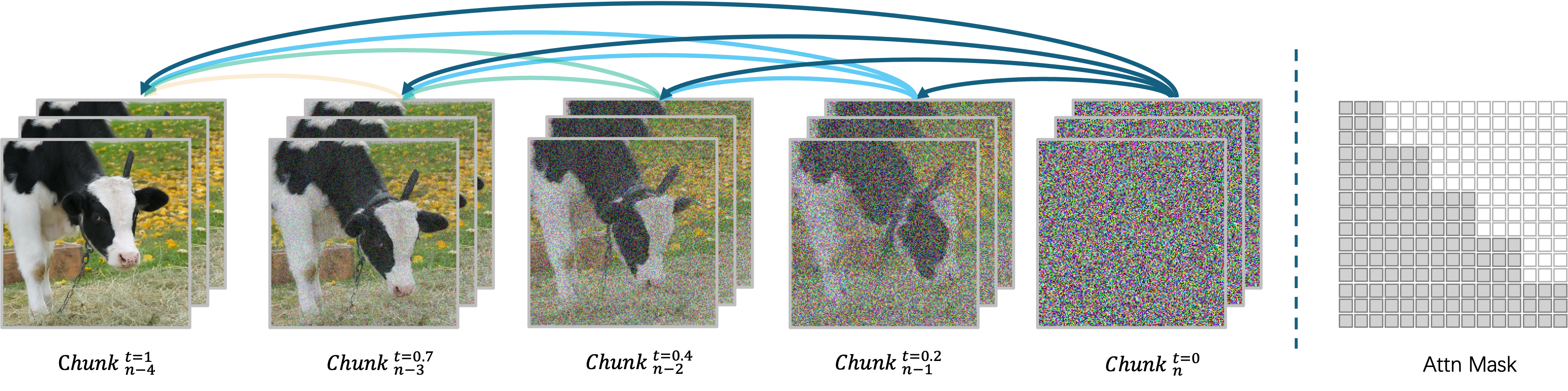

Algoritmo di Denoising Autoregressivo

Genera video segmento per segmento, permettendo l'elaborazione simultanea fino a quattro segmenti per una generazione video efficiente. Ogni segmento (24 fotogrammi) viene denoisato olisticamente, e il segmento successivo inizia non appena quello corrente raggiunge un certo livello di denoising.

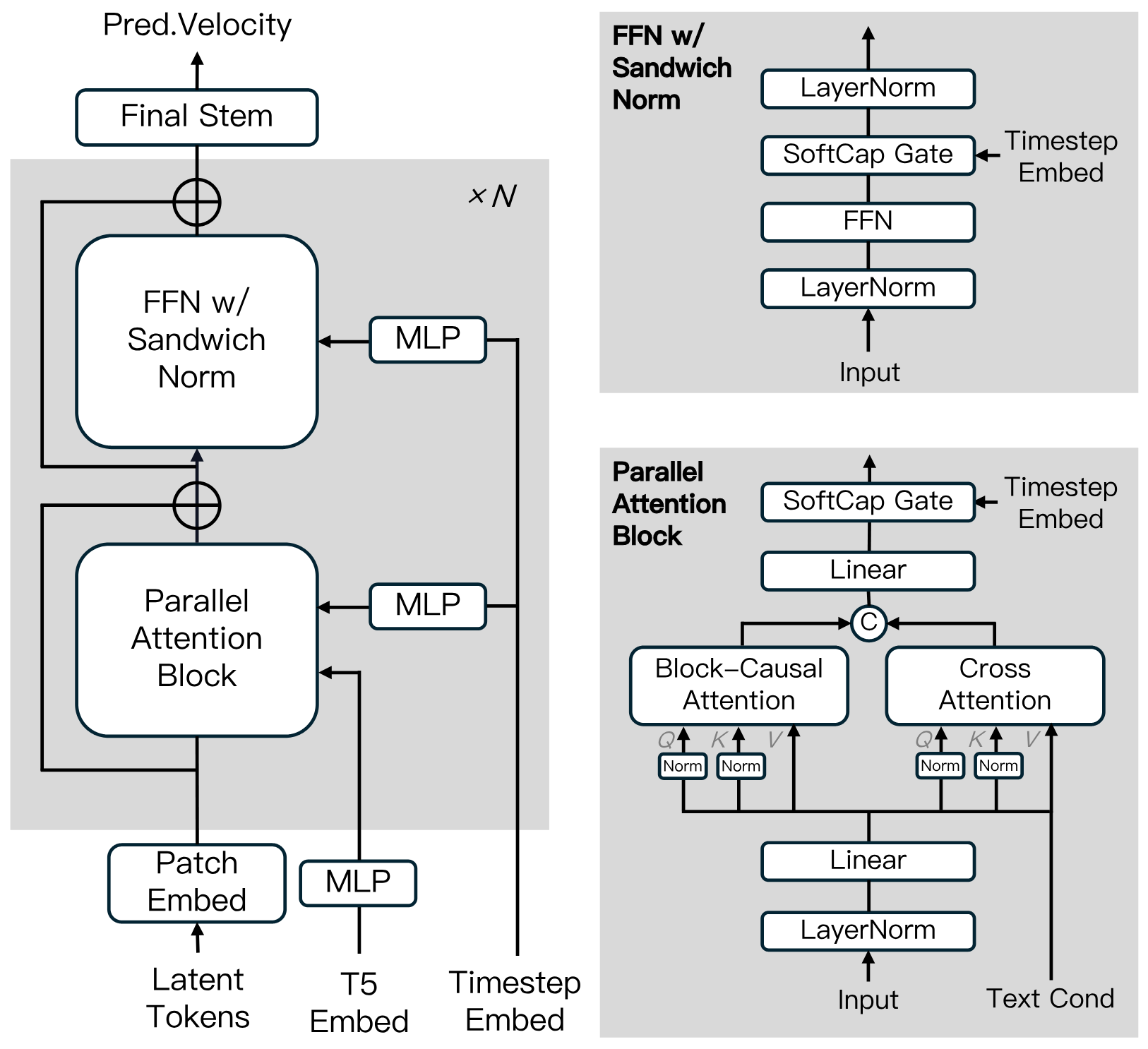

Architettura del Modello di Diffusione

Costruito sul Diffusion Transformer, incorporando innovazioni come Block-Causal Attention, Parallel Attention Block, QK-Norm e GQA. Include Sandwich Normalization in FFN, SwiGLU e Softcap Modulation per migliorare l'efficienza dell'addestramento e la stabilità su larga scala.

Algoritmo di Distillazione

Utilizza la distillazione shortcut per addestrare un singolo modello basato sulla velocità che supporta budget di inferenza variabili. Questo approccio garantisce un'inferenza efficiente con perdita minima di fedeltà.

MAGI-1: Zoo dei Modelli

Forniamo i pesi pre-addestrati per MAGI-1, inclusi i modelli 24B e 4.5B, così come i corrispondenti modelli distillati e distillati+quantizzati. I link ai pesi dei modelli sono mostrati nella tabella.

| Modello | Link | Macchina Raccomandata |

|---|---|---|

| T5 | T5 | - |

| MAGI-1-VAE | MAGI-1-VAE | - |

| MAGI-1-24B | MAGI-1-24B | H100/H800 * 8 |

| MAGI-1-24B-distill | MAGI-1-24B-distill | H100/H800 * 8 |

| MAGI-1-24B-distill+fp8_quant | MAGI-1-24B-distill+fp8_quant | H100/H800 * 4 o RTX 4090 * 8 |

| MAGI-1-4.5B | MAGI-1-4.5B | RTX 4090 * 1 |

MAGI-1: Risultati della Valutazione

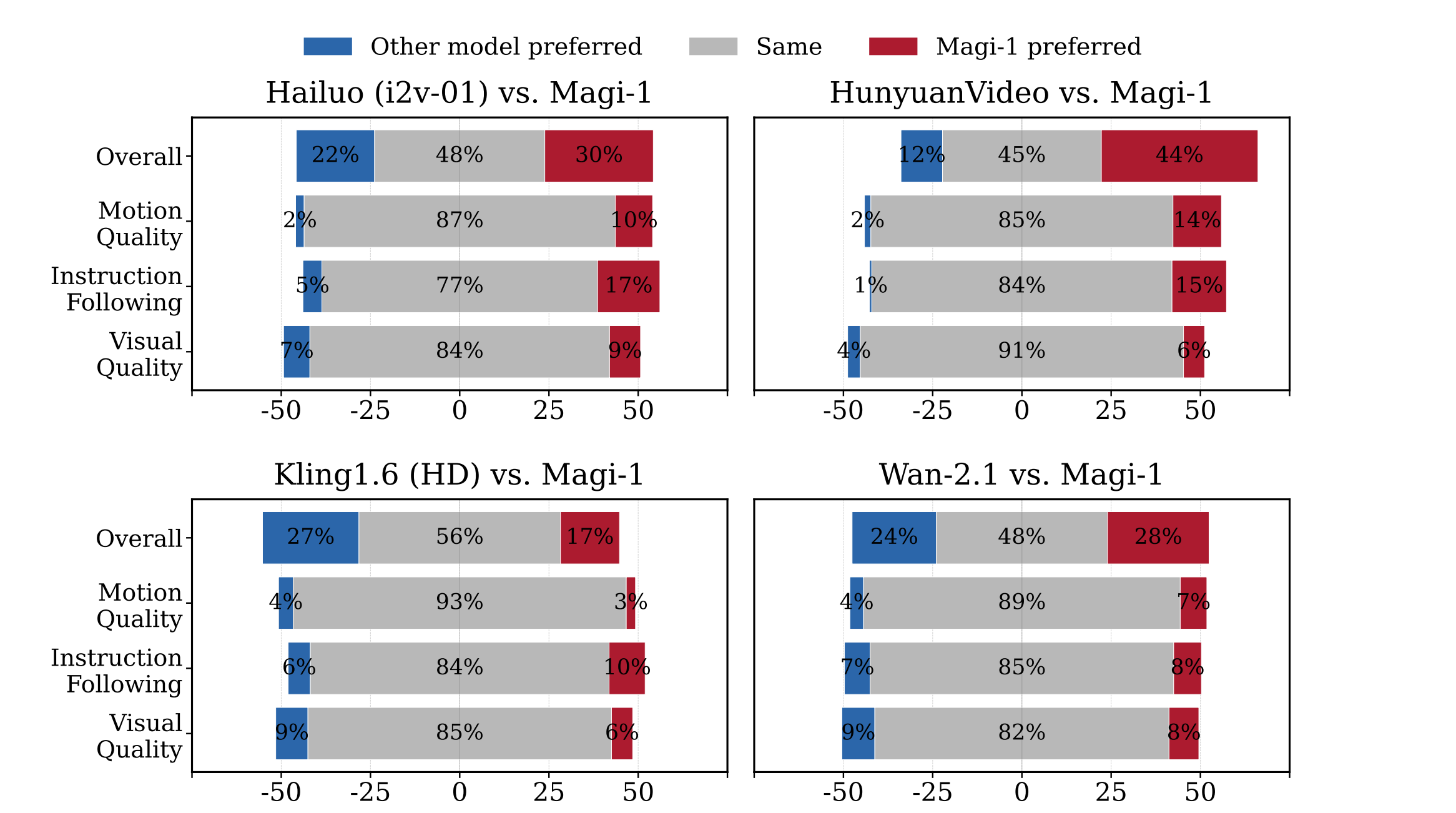

Valutazione Umana

MAGI-1 supera altri modelli open-source come Wan-2.1, , Hailuo e HunyuanVideo in termini di seguimento delle istruzioni e qualità del movimento, rendendolo un forte concorrente dei modelli commerciali closed-source.

Valutazione Fisica

MAGI-1 dimostra precisione superiore nel prevedere il comportamento fisico attraverso la continuazione video, superando significativamente i modelli esistenti.

| Model | Phys. IQ Score ↑ | Spatial IoU ↑ | Spatio Temporal ↑ | Weighted Spatial IoU ↑ | MSE ↓ |

|---|---|---|---|---|---|

| V2V Models | |||||

| Magi (V2V) | 56.02 | 0.367 | 0.270 | 0.304 | 0.005 |

| VideoPoet (V2V) | 29.50 | 0.204 | 0.164 | 0.137 | 0.010 |

| I2V Models | |||||

| Magi (I2V) | 30.23 | 0.203 | 0.151 | 0.154 | 0.012 |

| Kling1.6 (I2V) | 23.64 | 0.197 | 0.086 | 0.144 | 0.025 |

| VideoPoet (I2V) | 20.30 | 0.141 | 0.126 | 0.087 | 0.012 |

| Gen 3 (I2V) | 22.80 | 0.201 | 0.115 | 0.116 | 0.015 |

| Wan2.1 (I2V) | 20.89 | 0.153 | 0.100 | 0.112 | 0.023 |

| Sora (I2V) | 10.00 | 0.138 | 0.047 | 0.063 | 0.030 |

| GroundTruth | 100.0 | 0.678 | 0.535 | 0.577 | 0.002 |

Perché Scegliere MAGI-1

Sperimenta la prossima generazione di creazione video AI con MAGI-1, dove la tecnologia all'avanguardia incontra la trasparenza open-source.

Generazione Video Fluida

Prendi il controllo dei tuoi contenuti con regolazioni temporali precise al fotogramma, assicurando che i tuoi video soddisfino le specifiche creative esatte.

Controllo Preciso della Timeline

Produci video con visuali chiare e dettagliate e movimento fluido, garantendo un'esperienza professionale e coinvolgente.

Qualità del Movimento Migliorata

Sperimenta movimenti realistici con il nostro avanzato processamento del movimento, eliminando le transizioni robotiche per video dall'aspetto veramente naturale.

Innovazione Open-Source

Unisciti a un ecosistema trasparente dove tutti i modelli e la ricerca sono disponibili gratuitamente, promuovendo il miglioramento collaborativo e l'innovazione.

Domande Frequenti su MAGI-1

Cos'è MAGI-1?

MAGI-1 AI è un modello avanzato di generazione video autoregressivo sviluppato da SandAI, progettato per generare video di alta qualità predicendo sequenze di segmenti video in modo autoregressivo. Questo modello è addestrato per ridurre il rumore dei segmenti video, permettendo la modellazione temporale causale e supportando la generazione in streaming.

Quali sono le caratteristiche principali di MAGI-1?

Le caratteristiche del modello di generazione video MAGI-1 AI includono un VAE basato su Transformer per decodifica rapida e qualità di ricostruzione competitiva, un algoritmo di denoising autoregressivo per generazione video efficiente, e un'architettura del modello di diffusione che migliora l'efficienza dell'addestramento e la stabilità su larga scala. Supporta anche la generazione controllabile tramite prompting per segmenti, permettendo transizioni di scena fluide, sintesi a lungo termine e controllo dettagliato guidato dal testo.

Come gestisce MAGI-1 la generazione video?

MAGI-1 AI genera video segmento per segmento invece che come un tutto unico. Ogni segmento (24 fotogrammi) viene denoisato olisticamente, e la generazione del segmento successivo inizia non appena quello corrente raggiunge un certo livello di denoising. Questo design della pipeline permette l'elaborazione simultanea fino a quattro segmenti per una generazione video efficiente.

Quali varianti del modello sono disponibili per MAGI-1?

Le varianti del modello per il video MAGI-1 includono il modello 24B ottimizzato per la generazione video ad alta fedeltà e il modello 4.5B adatto per ambienti con risorse limitate. Sono disponibili anche modelli distillati e quantizzati per un'inferenza più veloce.

Come si comporta MAGI-1 nelle valutazioni?

MAGI-1 AI raggiunge prestazioni all'avanguardia tra i modelli open-source, eccellendo nel seguire le istruzioni e nella qualità del movimento, posizionandosi come un forte potenziale concorrente dei modelli commerciali closed-source come Kling1.6. Dimostra anche una precisione superiore nel prevedere il comportamento fisico attraverso la continuazione video, superando significativamente tutti i modelli esistenti.

Come posso eseguire MAGI-1?

MAGI-1 AI può essere eseguito usando Docker o direttamente dal codice sorgente. Docker è raccomandato per la facilità di configurazione. Gli utenti possono controllare input e output modificando i parametri negli script run.sh forniti.

Qual è la licenza di MAGI-1?

MAGI-1 è rilasciato sotto la Licenza Apache 2.0.

Cos'è la funzione 'Espansione Video Infinita' di MAGI-1?

La funzione 'Espansione Video Infinita' di MAGI-1 permette l'estensione fluida del contenuto video, combinata con il 'controllo dell'asse temporale a livello di secondo', permettendo agli utenti di ottenere transizioni di scena e editing raffinato attraverso il prompting segmento per segmento, soddisfacendo le esigenze della produzione cinematografica e dello storytelling.

Qual è il significato dell'architettura autoregressiva di MAGI-1?

Grazie ai vantaggi naturali dell'architettura autoregressiva, MAGI-1 raggiunge una precisione molto superiore nel prevedere il comportamento fisico attraverso la continuazione video, superando significativamente tutti i modelli esistenti.

Quali sono le applicazioni di MAGI-1?

MAGI-1 è progettato per varie applicazioni come la creazione di contenuti, lo sviluppo di giochi, la post-produzione cinematografica e l'istruzione. Offre uno strumento potente per la generazione video che può essere utilizzato in molteplici scenari.