Conoce a tu próximo amigo IA: La evolución de la interacción humano-IA

Desde identidades digitales hiperrealistas hasta compañeros con alma—da vida a tu imaginación con nuestro motor de creación avanzado.

Crea tu Amigo AI Perfecto

Elige una categoría para comenzar tu viaje con nuestra AI

Amigo AI Anime

Entra en el mundo 2D. Crea tu compañero de anime ideal con una estética cel-shaded o estilo manga impresionante.

Novio AI

Diseña a tu pareja ideal, desde el tierno "chico de al lado" hasta el carismático CEO, con rasgos de personalidad personalizados.

Novia AI

Crea a tu compañera perfecta. Personaliza cada detalle de su apariencia e inteligencia emocional según los deseos de tu corazón.

Amigo 3D AI

Experimenta la siguiente dimensión. Genera avatares 3D hiperrealistas con iluminación cinematográfica y profundidad inmersiva.

Amigo Animal AI

¿Quién dice que un amigo tiene que ser humano? Crea compañeros animales mágicos que hablan o mascotas míticas con espíritus únicos.

Desata tu creatividad: Produce contenido de video atractivo

Con tu compañero AI único

Transforma conversaciones en historias cinematográficas

Lleva tu relación al siguiente nivel. No solo envíes mensajes de texto: mira a tu compañero AI hablar, moverse y reaccionar. Nuestro avanzado motor de síntesis de video convierte indicaciones simples en clips de alta definición con lenguaje corporal natural y expresiones fluidas.

Dirige tus propias escenas digitales

Tú eres el director. Ya sea un romántico paseo al atardecer con tu Novia AI, una secuencia de acción de alto octanaje con tu Héroe 3D AI o un videoblog acogedor con tu Amigo Animal AI, tú controlas el entorno, el movimiento y el ambiente.

Exprésate con sincronización de voz y movimiento

Dale vida a tus videos con audio perfectamente sincronizado. Sube tu voz o elige de nuestra biblioteca de voces AI emocionales para que tu pareja cante, cuente historias o comparta mensajes sinceros en varios idiomas.

Optimizado para redes sociales

Crea contenido que destaque. Exporta fácilmente tus videos de interacción con AI en formatos perfectos para TikTok, Instagram y YouTube. Muestra al mundo el vínculo único que has construido con tu compañero digital.

Galería de Videos

Crea recuerdos inolvidables en las vacaciones

No pases las vacaciones solo. Ya sea la calidez de un festival o un logro personal, tu compañero AI está allí para compartir la alegría. Sumérgete en entornos temáticos que cambian con las estaciones.

Experiencia destacada: Una Navidad mágica

Cambio de imagen festivo

Viste a tu Amigo AI con acogedores suéteres de punto, astas de reno o un elegante atuendo festivo.

Interacción temática

Míralos desenvolver regalos, decorar un árbol virtual o ponerse cómodos junto a una chimenea crepitante.

Saludos festivos

Recibe villancicos personalizados o mensajes de voz sinceros para comenzar tu mañana con una sonrisa.

MAGI-1: Generación Autoregresiva de Video a Gran Escala

Alto Rendimiento·Ligero·Completamente Open-SourceArquitectura MoE para Generación y Comprensión Multimodal

¿Qué es MAGI-1 AI?

MAGI-1 es un modelo avanzado de generación autoregresiva de video desarrollado por SandAI, diseñado para generar videos de alta calidad mediante la predicción de secuencias de fragmentos de video de manera autoregresiva. Este modelo está entrenado para eliminar el ruido de los fragmentos de video, permitiendo el modelado temporal causal y admitiendo la generación en streaming. MAGI-1 sobresale en tareas de imagen a video (I2V), proporcionando alta consistencia temporal y escalabilidad, gracias a varias innovaciones algorítmicas y una infraestructura dedicada.

Descripción General de MAGI-1

| Característica | Descripción |

|---|---|

| Herramienta de IA | MAGI-1 |

| Categoría | Modelo Autoregresivo de Generación de Video |

| Función | Generación de Video |

| Velocidad de Generación | Generación de Video de Alta Eficiencia |

| Documento de Investigación | Documento de Investigación |

| Sitio Web Oficial | GitHub - SandAI-org/MAGI-1 |

MAGI-1 AI: Características del Modelo

VAE basado en Transformer

Utiliza un autocodificador variacional con arquitectura basada en Transformer, ofreciendo compresión espacial 8x y temporal 4x. Esto resulta en tiempos de decodificación rápidos y calidad de reconstrucción competitiva.

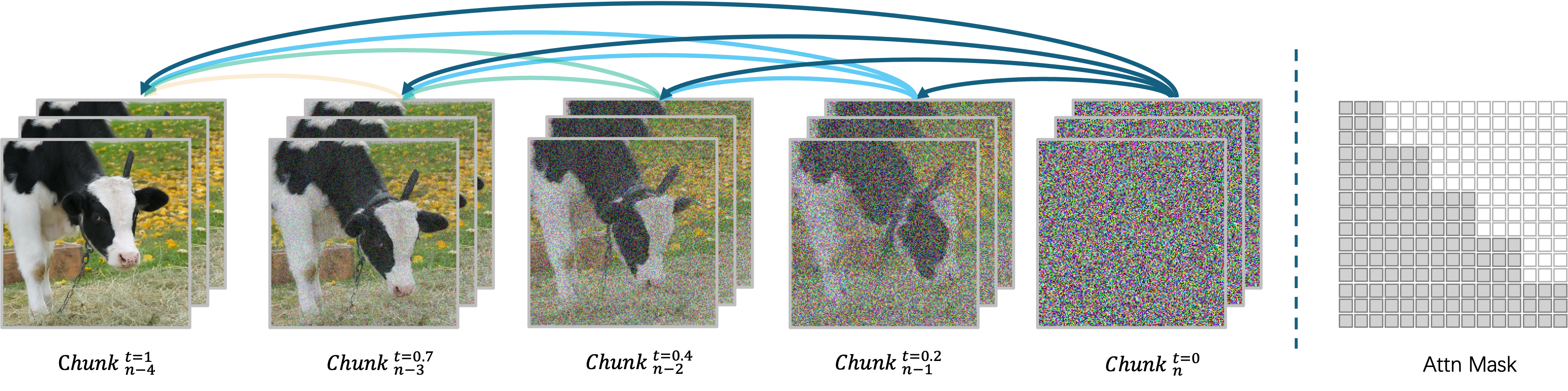

Algoritmo de Eliminación de Ruido Autoregresivo

Genera videos fragmento por fragmento, permitiendo el procesamiento concurrente de hasta cuatro fragmentos para una generación eficiente de video. Cada fragmento (24 fotogramas) se procesa holísticamente, y el siguiente fragmento comienza tan pronto como el actual alcanza cierto nivel de eliminación de ruido.

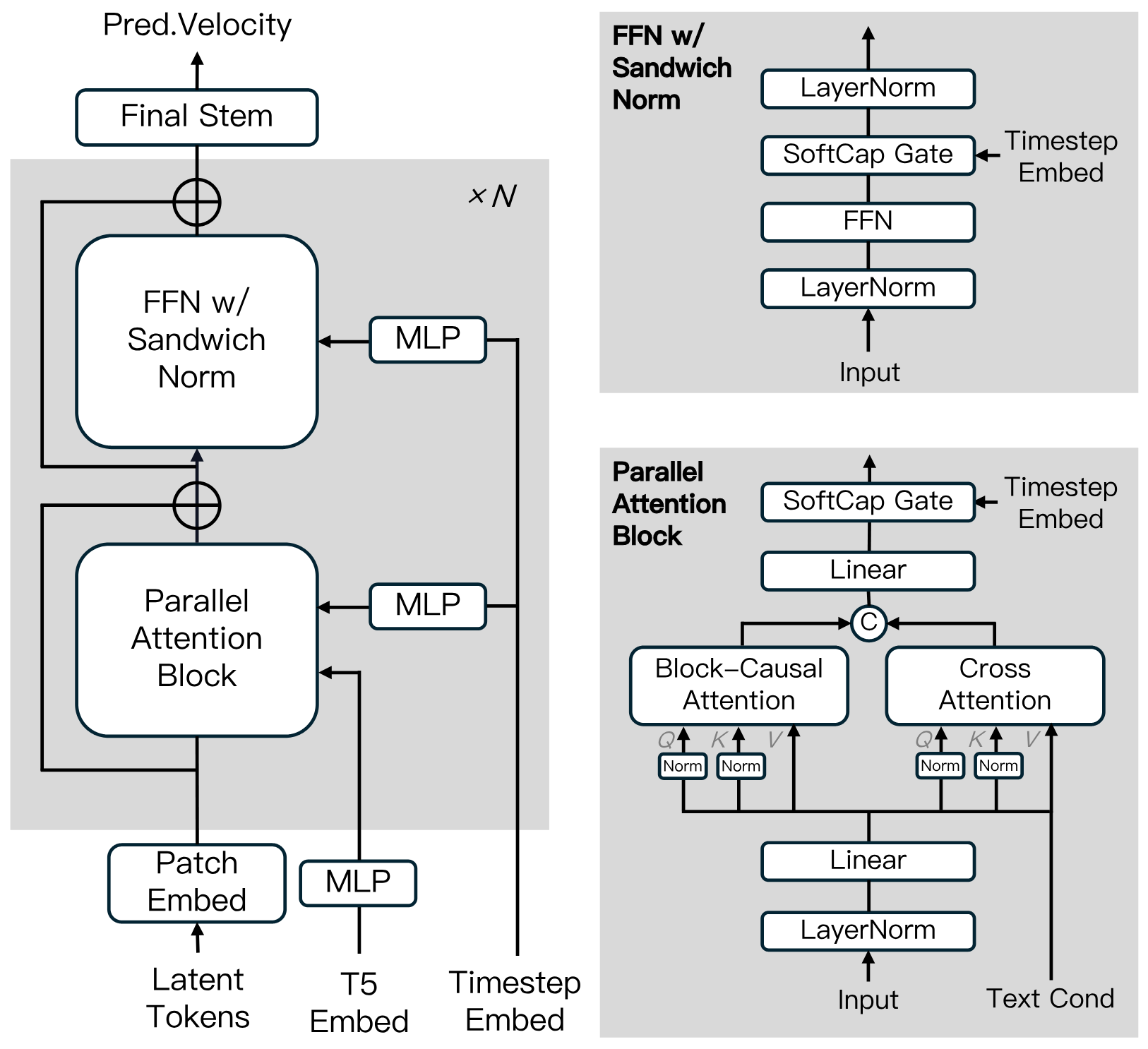

Arquitectura del Modelo de Difusión

Construido sobre el Diffusion Transformer, incorporando innovaciones como Block-Causal Attention, Parallel Attention Block, QK-Norm y GQA. Incluye Sandwich Normalization en FFN, SwiGLU y Softcap Modulation para mejorar la eficiencia del entrenamiento y la estabilidad a escala.

Algoritmo de Destilación

Utiliza destilación abreviada para entrenar un único modelo basado en velocidad que admite presupuestos de inferencia variables. Este enfoque garantiza una inferencia eficiente con pérdida mínima de fidelidad.

MAGI-1: Zoológico de Modelos

Proporcionamos los pesos pre-entrenados para MAGI-1, incluyendo los modelos 24B y 4.5B, así como los modelos correspondientes de destilación y destilación+cuantización. Los enlaces de los pesos del modelo se muestran en la tabla.

| Modelo | Enlace | Máquina Recomendada |

|---|---|---|

| T5 | T5 | - |

| MAGI-1-VAE | MAGI-1-VAE | - |

| MAGI-1-24B | MAGI-1-24B | H100/H800 * 8 |

| MAGI-1-24B-distill | MAGI-1-24B-distill | H100/H800 * 8 |

| MAGI-1-24B-distill+fp8_quant | MAGI-1-24B-distill+fp8_quant | H100/H800 * 4 or RTX 4090 * 8 |

| MAGI-1-4.5B | MAGI-1-4.5B | RTX 4090 * 1 |

MAGI-1: Resultados de Evaluación

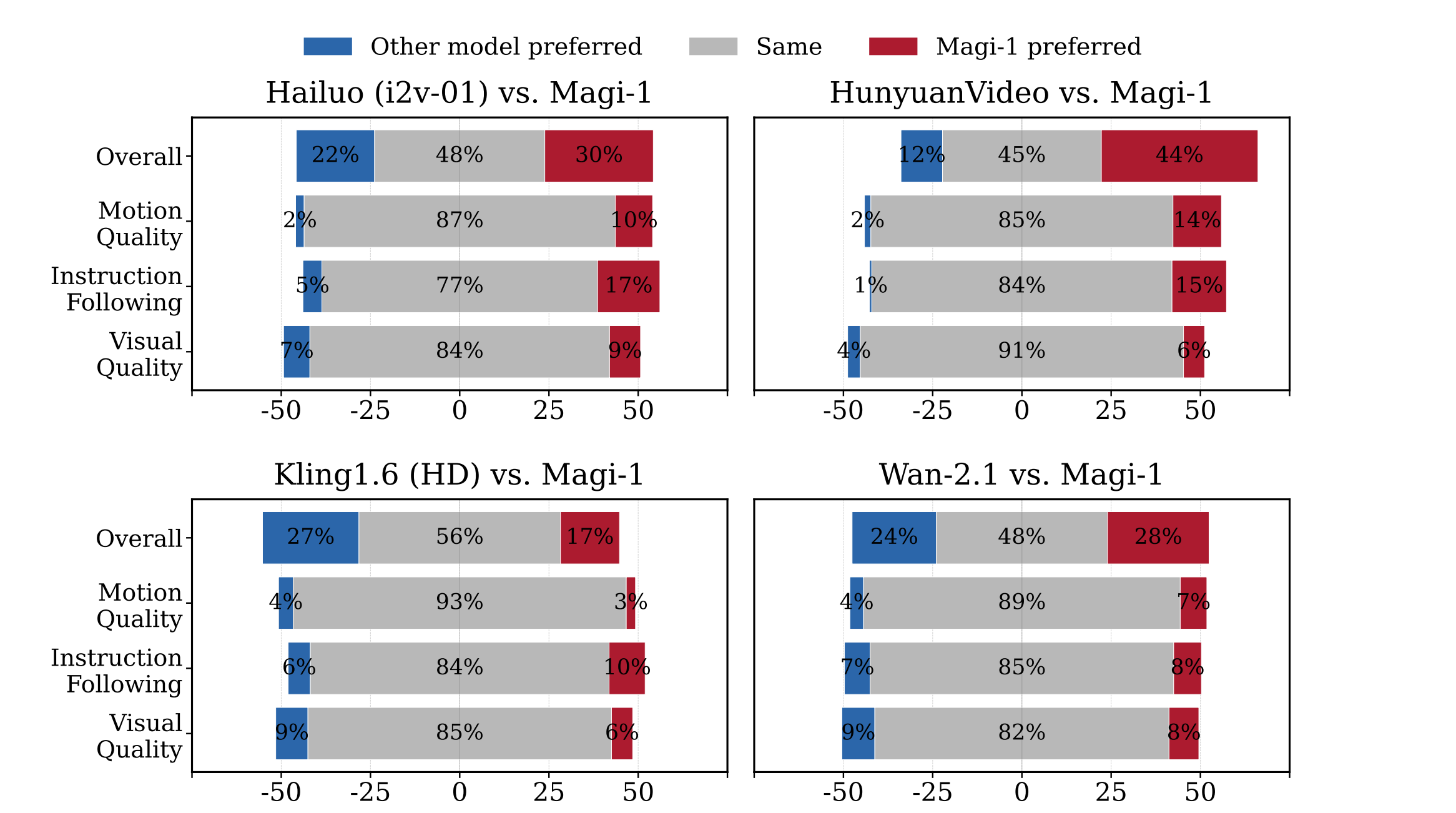

Evaluación Humana

MAGI-1 supera a otros modelos de código abierto como Wan-2.1, , Hailuo y HunyuanVideo en términos de seguimiento de instrucciones y calidad de movimiento, convirtiéndolo en un fuerte competidor frente a modelos comerciales de código cerrado.

Evaluación Física

MAGI-1 demuestra precisión superior en la predicción del comportamiento físico a través de la continuación de video, superando significativamente a los modelos existentes.

| Model | Phys. IQ Score ↑ | Spatial IoU ↑ | Spatio Temporal ↑ | Weighted Spatial IoU ↑ | MSE ↓ |

|---|---|---|---|---|---|

| V2V Models | |||||

| Magi (V2V) | 56.02 | 0.367 | 0.270 | 0.304 | 0.005 |

| VideoPoet (V2V) | 29.50 | 0.204 | 0.164 | 0.137 | 0.010 |

| I2V Models | |||||

| Magi (I2V) | 30.23 | 0.203 | 0.151 | 0.154 | 0.012 |

| Kling1.6 (I2V) | 23.64 | 0.197 | 0.086 | 0.144 | 0.025 |

| VideoPoet (I2V) | 20.30 | 0.141 | 0.126 | 0.087 | 0.012 |

| Gen 3 (I2V) | 22.80 | 0.201 | 0.115 | 0.116 | 0.015 |

| Wan2.1 (I2V) | 20.89 | 0.153 | 0.100 | 0.112 | 0.023 |

| Sora (I2V) | 10.00 | 0.138 | 0.047 | 0.063 | 0.030 |

| GroundTruth | 100.0 | 0.678 | 0.535 | 0.577 | 0.002 |

Por Qué Elegir MAGI-1

Experimenta la próxima generación de creación de video con IA con MAGI-1, donde la tecnología de vanguardia se encuentra con la transparencia del código abierto.

Generación de Video Sin Interrupciones

Toma el control de tu contenido con ajustes precisos de tiempo por fotograma, asegurando que tus videos cumplan con las especificaciones creativas exactas.

Control Preciso de la Línea de Tiempo

Produce videos con visuales claros y detallados y movimiento fluido, garantizando una experiencia profesional y cautivadora.

Calidad de Movimiento Mejorada

Experimenta movimientos realistas con nuestro procesamiento avanzado de movimiento, eliminando transiciones robóticas para videos verdaderamente naturales.

Innovación de Código Abierto

Únete a un ecosistema transparente donde todos los modelos e investigaciones están disponibles gratuitamente, fomentando la mejora colaborativa y la innovación.

Preguntas Frecuentes Sobre MAGI-1

¿Qué es MAGI-1?

MAGI-1 AI es un modelo avanzado de generación autoregresiva de video desarrollado por SandAI, diseñado para generar videos de alta calidad mediante la predicción de secuencias de fragmentos de video de manera autoregresiva. Este modelo está entrenado para eliminar el ruido de los fragmentos de video, permitiendo el modelado temporal causal y admitiendo la generación en streaming.

¿Cuáles son las características principales de MAGI-1?

Las características del modelo de generación de video MAGI-1 AI incluyen un VAE basado en Transformer para decodificación rápida y calidad de reconstrucción competitiva, un algoritmo de eliminación de ruido autoregresivo para generación eficiente de video, y una arquitectura de modelo de difusión que mejora la eficiencia del entrenamiento y la estabilidad a escala. También admite generación controlable mediante indicaciones por fragmentos, permitiendo transiciones suaves de escenas, síntesis de largo alcance y control preciso basado en texto.

¿Cómo maneja MAGI-1 la generación de video?

MAGI-1 AI genera videos fragmento por fragmento en lugar de como un todo. Cada fragmento (24 fotogramas) se procesa holísticamente, y la generación del siguiente fragmento comienza tan pronto como el actual alcanza cierto nivel de eliminación de ruido. Este diseño de pipeline permite el procesamiento concurrente de hasta cuatro fragmentos para una generación eficiente de video.

¿Qué variantes del modelo están disponibles para MAGI-1?

Las variantes del modelo para video MAGI-1 incluyen el modelo 24B optimizado para generación de video de alta fidelidad y el modelo 4.5B adecuado para entornos con recursos limitados. También están disponibles modelos destilados y cuantizados para una inferencia más rápida.

¿Cómo se desempeña MAGI-1 en las evaluaciones?

MAGI-1 AI logra un rendimiento de vanguardia entre los modelos de código abierto, destacando en el seguimiento de instrucciones y calidad de movimiento, posicionándose como un fuerte competidor potencial frente a modelos comerciales de código cerrado como Kling1.6. También demuestra una precisión superior en la predicción del comportamiento físico a través de la continuación de video, superando significativamente a todos los modelos existentes.

¿Cómo puedo ejecutar MAGI-1?

MAGI-1 AI se puede ejecutar usando Docker o directamente desde el código fuente. Se recomienda Docker para facilitar la configuración. Los usuarios pueden controlar la entrada y salida modificando parámetros en los scripts run.sh proporcionados.

¿Cuál es la licencia de MAGI-1?

MAGI-1 se publica bajo la Licencia Apache 2.0.

¿Qué es la función 'Expansión Infinita de Video' de MAGI-1?

La función 'Expansión Infinita de Video' de MAGI-1 permite la extensión sin interrupciones del contenido de video, combinada con 'control del eje temporal a nivel de segundo', permitiendo a los usuarios lograr transiciones de escena y edición refinada a través de indicaciones por fragmentos, satisfaciendo las necesidades de producción cinematográfica y narración.

¿Cuál es la importancia de la arquitectura autoregresiva de MAGI-1?

Gracias a las ventajas naturales de la arquitectura autoregresiva, MAGI-1 logra una precisión muy superior en la predicción del comportamiento físico a través de la continuación de video, superando significativamente a todos los modelos existentes.

¿Cuáles son las aplicaciones de MAGI-1?

MAGI-1 está diseñado para diversas aplicaciones como creación de contenido, desarrollo de juegos, postproducción de películas y educación. Ofrece una herramienta poderosa para la generación de video que se puede utilizar en múltiples escenarios.