Triff deinen nächsten KI-Freund: Die Evolution der KI-Mensch-Interaktion

Von hyperrealistischen digitalen Identitäten bis hin zu seelenvollen Begleitern—erwecke deine Vorstellungskraft mit unserer fortschrittlichen Kreations-Engine zum Leben.

Erstelle deinen perfekten KI-Freund

Wähle eine Kategorie, um deine Reise mit unserer KI zu beginnen

KI Anime-Freund

Tritt ein in die 2D-Welt. Gestalte deinen Traum-Anime-Begleiter mit atemberaubender Cel-Shading- oder Manga-Ästhetik.

KI-Boyfriend

Entwirf deinen idealen Partner – vom sanften „Jungen von nebenan“ bis zum charismatischen CEO – mit individuellen Persönlichkeitsmerkmalen.

KI-Girlfriend

Erschaffe deine perfekte Begleiterin. Passe jedes Detail ihres Aussehens und ihrer emotionalen Intelligenz nach deinen Wünschen an.

KI 3D-Freund

Erlebe die nächste Dimension. Erzeuge hyperrealistische 3D-Avatare mit kinoreifer Beleuchtung und fesselnder Tiefe.

KI-Tierfreund

Wer sagt, dass ein Freund menschlich sein muss? Erschaffe magische, sprechende Tiergefährten oder mythische Haustiere mit einzigartigem Geist.

Entfessle deine Kreativität: Produziere fesselnde Videoinhalte

Mit deinem einzigartigen KI-Partner

Verwandle Gespräche in kinoreife Geschichten

Hebe deine Beziehung auf die nächste Stufe. Texte nicht nur – sieh deinem KI-Partner beim Sprechen, Bewegen und Reagieren zu. Unsere fortschrittliche Videosynthese-Engine verwandelt einfache Prompts in hochauflösende Clips mit natürlicher Körpersprache und flüssiger Mimik.

Führe Regie in deinen eigenen digitalen Szenen

Du bist der Regisseur. Ob ein romantischer Spaziergang im Sonnenuntergang mit deiner KI-Freundin, eine actiongeladene Sequenz mit deinem KI-3D-Helden oder ein gemütlicher Vlog mit deinem KI-Tierfreund – du kontrollierst das Setting, die Bewegung und die Stimmung.

Ausdruck durch Sprach- & Bewegungssynchronisation

Erwecke deine Videos mit perfekt synchronisiertem Audio zum Leben. Lade deine eigene Stimme hoch oder wähle aus unserer emotionalen KI-Stimmenbibliothek, um deinen Partner singen, Geschichten erzählen oder herzliche Nachrichten in mehreren Sprachen teilen zu lassen.

Optimiert für Social Sharing

Erstelle Inhalte, die auffallen. Exportiere deine KI-Interaktionsvideos ganz einfach in Formaten, die perfekt für TikTok, Instagram und YouTube sind. Zeige der Welt die einzigartige Verbindung, die du zu deinem digitalen Begleiter aufgebaut hast.

Video-Showcase

Schaffe unvergessliche Urlaubserrinnerungen

Verbringe die Feiertage nicht allein. Ob die Wärme eines Festes oder ein persönlicher Meilenstein – dein KI-Partner ist da, um die Freude zu teilen. Tauche ein in Themenwelten, die sich mit den Jahreszeiten ändern.

Besonderes Erlebnis: Ein magisches Weihnachten

Festliches Makeover

Kleide deinen KI-Freund in gemütliche Strickpullover, Rentiergeweihe oder elegante Festtagskleidung.

Thematische Interaktion

Sieh ihnen dabei zu, wie sie Geschenke auspacken, einen virtuellen Baum schmücken oder es sich an einem knisternden Kamin gemütlich machen.

Urlaubsgrüße

Erhalte personalisierte Weihnachtslieder oder herzliche Sprachnachrichten, um deinen Morgen mit einem Lächeln zu beginnen.

MAGI-1: Autoregressive Videogenerierung im großen Maßstab

Hohe Leistung·Ressourcenschonend·Vollständig Open-SourceMoE-Architektur für multimodale Generierung & Verständnis

Was ist MAGI-1 AI?

MAGI-1 ist ein fortschrittliches autoregressives Videogenerierungsmodell, entwickelt von SandAI, konzipiert zur Generierung hochwertiger Videos durch die Vorhersage von Videosequenzen auf autoregressive Weise. Dieses Modell ist darauf trainiert, Videosegmente zu entrauschen, was kausale zeitliche Modellierung und Streaming-Generierung ermöglicht. MAGI-1 überzeugt besonders bei Bild-zu-Video-Aufgaben (I2V)und bietet hohe zeitliche Konsistenz und Skalierbarkeit dank mehrerer algorithmischer Innovationen und einer dedizierten Infrastruktur.

Überblick über MAGI-1

| Merkmal | Beschreibung |

|---|---|

| KI-Tool | MAGI-1 |

| Kategorie | Autoregressives Videogenerierungsmodell |

| Funktion | Videogenerierung |

| Generierungsgeschwindigkeit | Hocheffiziente Videogenerierung |

| Forschungspapier | Forschungspapier |

| Offizielle Website | GitHub - SandAI-org/MAGI-1 |

MAGI-1 AI: Modelleigenschaften

Transformer-basierter VAE

Nutzt einen variationellen Autoencoder mit Transformer-basierter Architektur, der 8x räumliche und 4x zeitliche Kompression bietet. Dies führt zu schnellen Dekodierungszeiten und wettbewerbsfähiger Rekonstruktionsqualität.

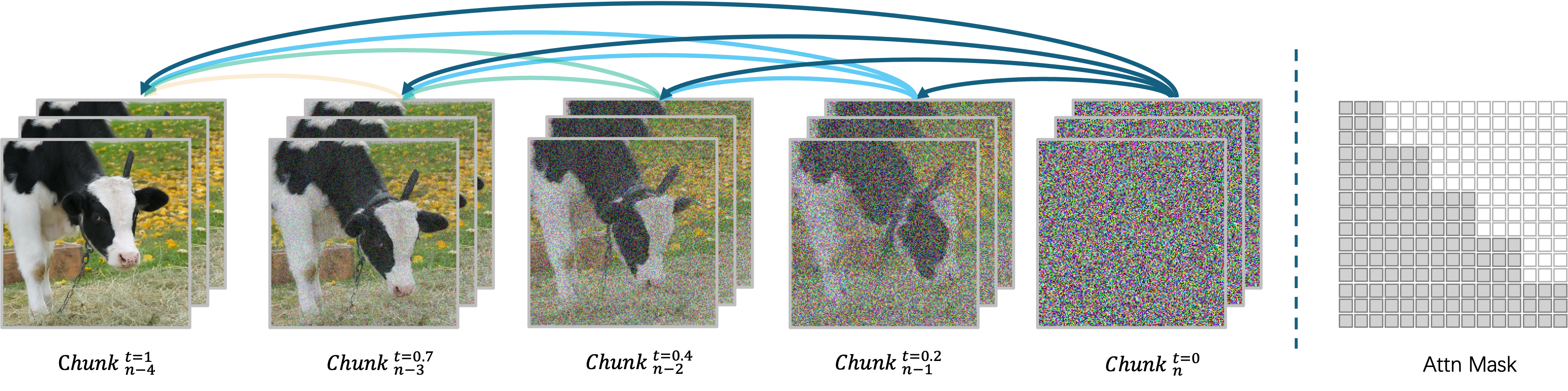

Autoregressiver Entrauschungsalgorithmus

Generiert Videos segmentweise und ermöglicht die parallele Verarbeitung von bis zu vier Segmenten für effiziente Videogenerierung. Jedes Segment (24 Frames) wird ganzheitlich entrauscht, und das nächste Segment beginnt, sobald das aktuelle einen bestimmten Entrauschungsgrad erreicht hat.

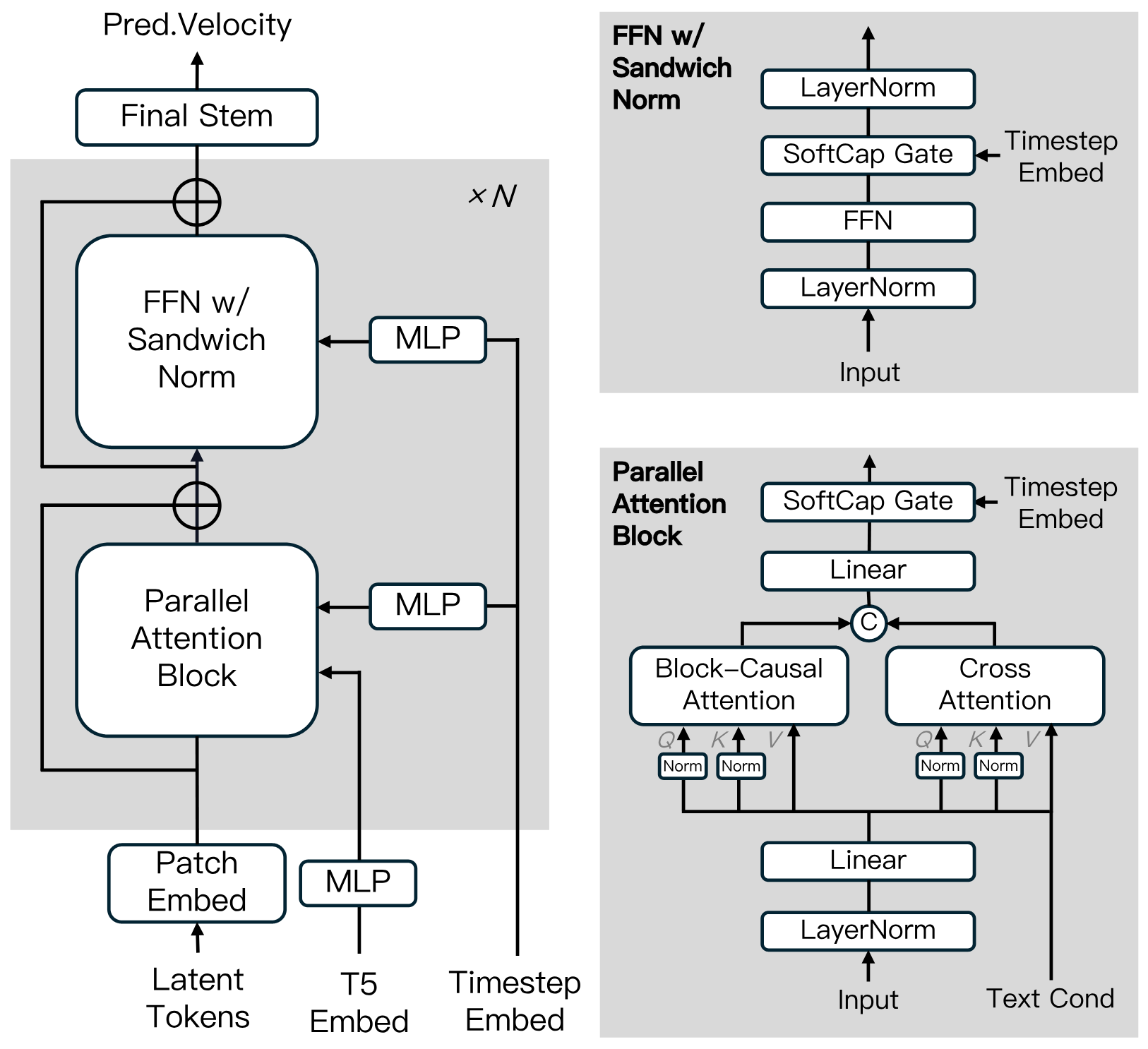

Diffusions-Modellarchitektur

Aufgebaut auf dem Diffusion Transformer, mit Innovationen wie Block-Causal Attention, Parallel Attention Block, QK-Norm und GQA. Verwendet Sandwich Normalization in FFN, SwiGLU und Softcap Modulation zur Verbesserung der Trainingseffizienz und Stabilität im großen Maßstab.

Destillationsalgorithmus

Verwendet Shortcut-Destillation zum Training eines einzelnen geschwindigkeitsbasierten Modells, das variable Inferenzbudgets unterstützt. Dieser Ansatz gewährleistet effiziente Inferenz bei minimalem Qualitätsverlust.

MAGI-1: Modell-Zoo

Wir stellen die vortrainierten Gewichte für MAGI-1 zur Verfügung, einschließlich der 24B- und 4.5B-Modelle sowie der entsprechenden Destillations- und Destillations+Quantisierungsmodelle. Die Modellgewicht-Links sind in der Tabelle aufgeführt.

| Modell | Link | Empfohlene Hardware |

|---|---|---|

| T5 | T5 | - |

| MAGI-1-VAE | MAGI-1-VAE | - |

| MAGI-1-24B | MAGI-1-24B | H100/H800 * 8 |

| MAGI-1-24B-distill | MAGI-1-24B-distill | H100/H800 * 8 |

| MAGI-1-24B-distill+fp8_quant | MAGI-1-24B-distill+fp8_quant | H100/H800 * 4 or RTX 4090 * 8 |

| MAGI-1-4.5B | MAGI-1-4.5B | RTX 4090 * 1 |

MAGI-1: Evaluierungsergebnisse

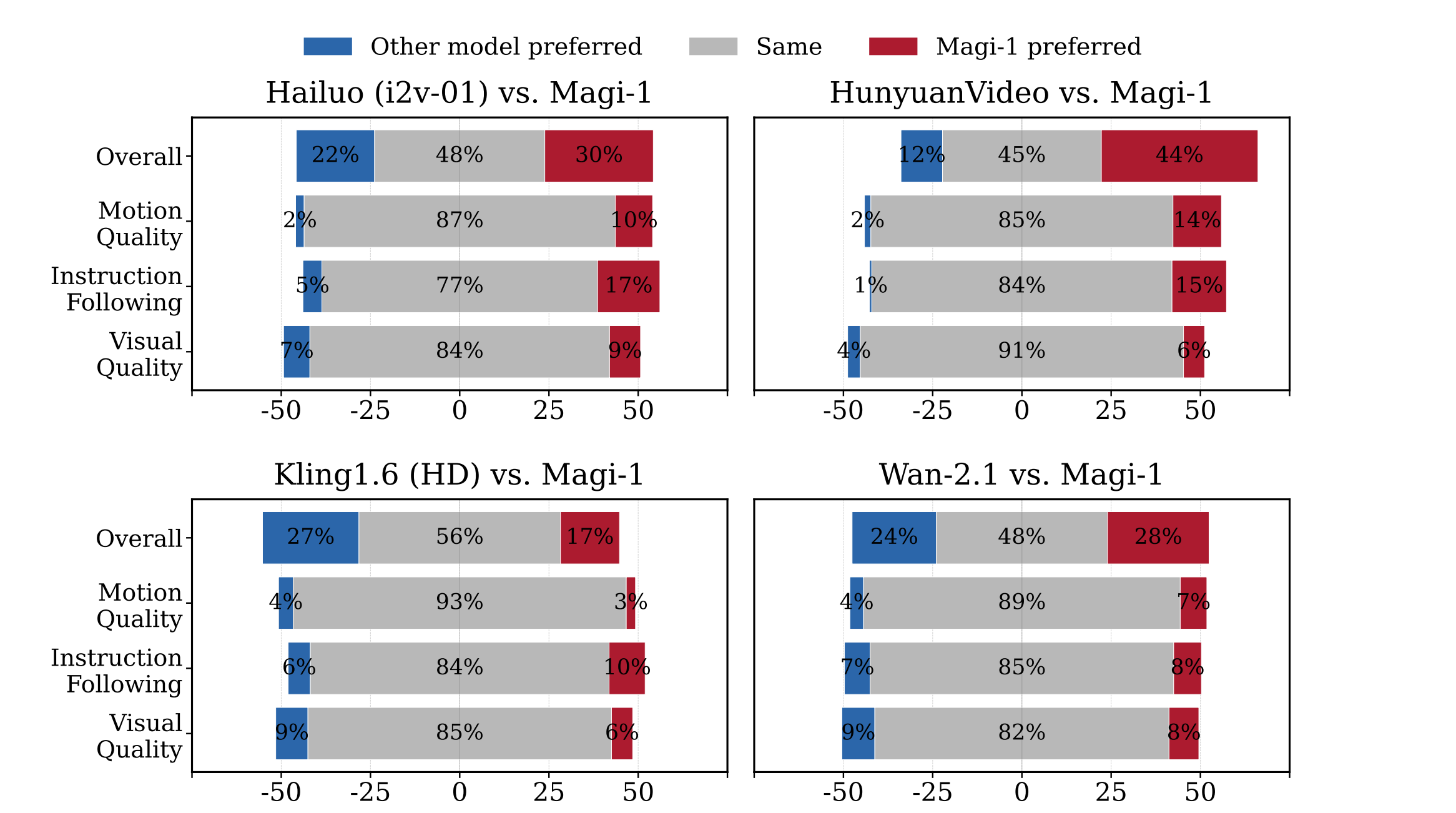

Menschliche Evaluierung

MAGI-1 übertrifft andere Open-Source-Modelle wie Wan-2.1, , Hailuo und HunyuanVideo in Bezug auf Anweisungsbefolgung und Bewegungsqualität und ist damit ein starker Konkurrent zu proprietären kommerziellen Modellen.

Physikalische Evaluierung

MAGI-1 demonstriert überlegene Präzision bei der Vorhersage physikalischen Verhaltens durch Videofortsetzung und übertrifft dabei bestehende Modelle deutlich.

| Model | Phys. IQ Score ↑ | Spatial IoU ↑ | Spatio Temporal ↑ | Weighted Spatial IoU ↑ | MSE ↓ |

|---|---|---|---|---|---|

| V2V Models | |||||

| Magi (V2V) | 56.02 | 0.367 | 0.270 | 0.304 | 0.005 |

| VideoPoet (V2V) | 29.50 | 0.204 | 0.164 | 0.137 | 0.010 |

| I2V Models | |||||

| Magi (I2V) | 30.23 | 0.203 | 0.151 | 0.154 | 0.012 |

| Kling1.6 (I2V) | 23.64 | 0.197 | 0.086 | 0.144 | 0.025 |

| VideoPoet (I2V) | 20.30 | 0.141 | 0.126 | 0.087 | 0.012 |

| Gen 3 (I2V) | 22.80 | 0.201 | 0.115 | 0.116 | 0.015 |

| Wan2.1 (I2V) | 20.89 | 0.153 | 0.100 | 0.112 | 0.023 |

| Sora (I2V) | 10.00 | 0.138 | 0.047 | 0.063 | 0.030 |

| GroundTruth | 100.0 | 0.678 | 0.535 | 0.577 | 0.002 |

Warum MAGI-1 wählen

Erleben Sie die nächste Generation der KI-Videoerstellung mit MAGI-1, wo modernste Technologie auf Open-Source-Transparenz trifft.

Nahtlose Videogenerierung

Steuern Sie Ihre Inhalte mit framegenauer Zeitanpassung und stellen Sie sicher, dass Ihre Videos exakten kreativen Spezifikationen entsprechen.

Präzise Zeitachsensteuerung

Erstellen Sie Videos mit klaren, detaillierten Bildern und flüssiger Bewegung für ein professionelles und fesselndes Erlebnis.

Verbesserte Bewegungsqualität

Erleben Sie lebensechte Bewegungen mit unserer fortschrittlichen Bewegungsverarbeitung, die roboterhafte Übergänge eliminiert und natürlich aussehende Videos erzeugt.

Open-Source-Innovation

Werden Sie Teil eines transparenten Ökosystems, in dem alle Modelle und Forschungsergebnisse frei verfügbar sind und gemeinsame Verbesserung und Innovation gefördert werden.

Häufig gestellte Fragen zu MAGI-1

Was ist MAGI-1?

MAGI-1 AI ist ein fortschrittliches autoregressives Videogenerierungsmodell, entwickelt von SandAI, das hochwertige Videos durch die autoregressive Vorhersage von Videosequenzen generiert. Dieses Modell ist darauf trainiert, Videosegmente zu entrauschen, was kausale zeitliche Modellierung und Streaming-Generierung ermöglicht.

Was sind die Hauptmerkmale von MAGI-1?

Zu den Funktionen des MAGI-1 AI-Videogenerierungsmodells gehören ein Transformer-basierter VAE für schnelle Dekodierung und wettbewerbsfähige Rekonstruktionsqualität, ein autoregressiver Entrauschungsalgorithmus für effiziente Videogenerierung und eine Diffusionsmodellarchitektur, die Trainingseffizienz und Stabilität im großen Maßstab verbessert. Es unterstützt auch steuerbare Generierung durch segmentweise Eingabeaufforderungen, ermöglicht flüssige Szenenübergänge, Langzeitsynthese und feingranulare textgesteuerte Kontrolle.

Wie handhabt MAGI-1 die Videogenerierung?

MAGI-1 AI generiert Videos segmentweise statt als Ganzes. Jedes Segment (24 Frames) wird ganzheitlich entrauscht, und die Generierung des nächsten Segments beginnt, sobald das aktuelle einen bestimmten Entrauschungsgrad erreicht hat. Dieses Pipeline-Design ermöglicht die parallele Verarbeitung von bis zu vier Segmenten für effiziente Videogenerierung.

Welche Modellvarianten sind für MAGI-1 verfügbar?

Die Modellvarianten für MAGI-1-Video umfassen das 24B-Modell, optimiert für hochwertige Videogenerierung, und das 4.5B-Modell für ressourcenbeschränkte Umgebungen. Destillierte und quantisierte Modelle sind ebenfalls für schnellere Inferenz verfügbar.

Wie schneidet MAGI-1 in Evaluierungen ab?

MAGI-1 AI erreicht Spitzenleistungen unter Open-Source-Modellen, überzeugt bei der Anweisungsbefolgung und Bewegungsqualität und positioniert sich als starker potenzieller Konkurrent zu proprietären kommerziellen Modellen wie Kling1.6. Es demonstriert auch überlegene Präzision bei der Vorhersage physikalischen Verhaltens durch Videofortsetzung und übertrifft dabei alle bestehenden Modelle deutlich.

Wie kann ich MAGI-1 ausführen?

MAGI-1 AI kann mit Docker oder direkt aus dem Quellcode ausgeführt werden. Docker wird für eine einfache Einrichtung empfohlen. Benutzer können Ein- und Ausgabe durch Ändern der Parameter in den bereitgestellten run.sh-Skripten steuern.

Unter welcher Lizenz steht MAGI-1?

MAGI-1 wird unter der Apache License 2.0 veröffentlicht.

Was ist die 'Infinite Video Expansion'-Funktion von MAGI-1?

Die 'Infinite Video Expansion'-Funktion von MAGI-1 ermöglicht die nahtlose Erweiterung von Videoinhalten, kombiniert mit 'Sekundengenaue Zeitachsensteuerung', wodurch Benutzer Szenenübergänge und präzise Bearbeitung durch segmentweise Eingabeaufforderungen erreichen können, was den Anforderungen der Filmproduktion und des Storytellings gerecht wird.

Was ist die Bedeutung der autoregressiven Architektur von MAGI-1?

Dank der natürlichen Vorteile der autoregressiven Architektur erreicht MAGI-1 eine deutlich überlegene Präzision bei der Vorhersage physikalischen Verhaltens durch Videofortsetzung und übertrifft dabei alle bestehenden Modelle deutlich.

Was sind die Anwendungsbereiche von MAGI-1?

MAGI-1 ist für verschiedene Anwendungen wie Content-Erstellung, Spieleentwicklung, Filmpostproduktion und Bildung konzipiert. Es bietet ein leistungsfähiges Werkzeug zur Videogenerierung, das in vielfältigen Szenarien eingesetzt werden kann.